Definizione

L’entropia (tradotta dal greco antico – svolta, trasformazione) è una misura, il grado di disordine (caos) di qualsiasi sistema. Utilizzato nelle seguenti scienze esatte e naturali:

- In matematica, significa trovare il logaritmo del numero di stati di sistema disponibili;

- Nella scienza statistica, il valore probabilistico dell’insorgenza di qualsiasi stato macroscopico del sistema;

- In termodinamica (fisica), il grado di diffusione irreversibile dell’energia, ad es. il valore standard delle sue perdite, che sono inevitabili quando un corpo più caldo interagisce con uno più freddo;

- In informatica, significa la capacità di informazione del sistema. Un fatto interessante è il seguente: Claude Shannon (il fondatore di questo termine nella teoria dell’informazione) originariamente pensava di chiamare informazione entropica.

Quasi complicato

L’entropia è un concetto utilizzato in più di un’area dell’attività umana, quindi le sue definizioni possono essere alquanto vaghe. Questo termine riflette un valore e la sua essenza può essere smontata con semplici esempi. L’entropia è il grado di disordine, il grado di incertezza e disordine.

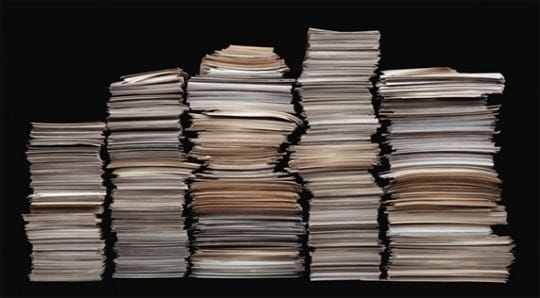

L’alta entropia può essere visualizzata come una strada con frammenti di carta sparsi. Se le carte sono impilate ordinatamente in una pila, il sistema viene ordinato e l’entropia è bassa. I valori di entropia devono essere abbassati, e per questo è necessario dedicare molto tempo, incollare le carte pezzo per pezzo e metterle in una pila.

Se si verifica l’entropia di un sistema chiuso, anche qui tutto è semplice. Un sistema chiuso può essere immaginato come un armadio chiuso, se le cose sono sparse al suo interno, non sarà possibile influenzarle dall’esterno e il caos nell’armadio sarà presente per molto tempo.

Nel tempo, le cose si decompongono e questo porterà all’ordine, ma le cose devono decomporsi a lungo, ad esempio, ci vorranno 5 anni per un calzino di lana e circa 40 anni per le scarpe di cuoio. In questo esempio, l’armadio funge da sistema isolato e la scomposizione delle cose al suo interno sta mettendo le cose in ordine nelle strutture.

Il minimo è l’entropia, che riguarda gli oggetti macroscopici, che possono essere osservati ad occhio nudo. Per quanto riguarda gli indicatori più alti, spesso hanno un vuoto.

Storia dell’origine

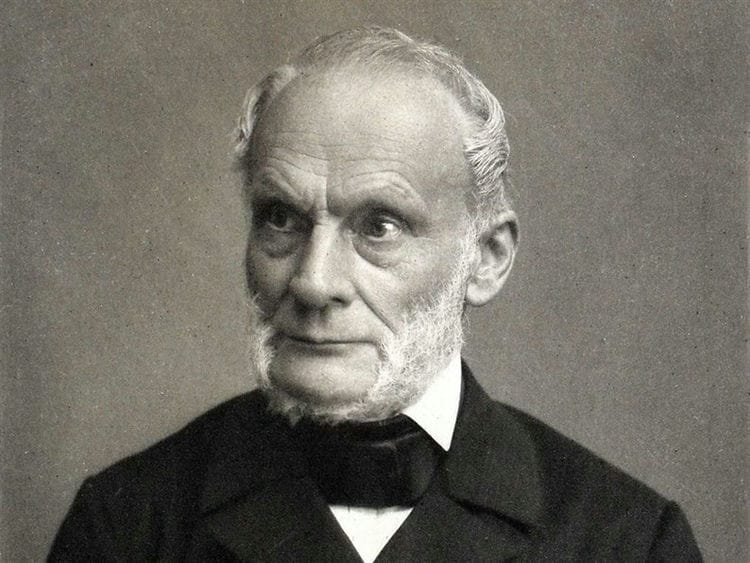

Per la prima volta, il concetto di entropia è stato introdotto nell’era dello sviluppo della termodinamica, quando è nata la necessità di studiare i processi che avvengono all’interno dei corpi termodinamici. Nel 1865 un fisico tedesco, Rudolf Clausius, con questo termine descriveva lo stato di un sistema in cui il calore ha la capacità di trasformarsi in altri tipi di energia (meccanica, chimica, luminosa, ecc.).

L’aumento dell’entropia è causato dall’afflusso di energia termica nel sistema ed è associato alla temperatura alla quale si verifica questo afflusso. La necessità di questo valore era dovuta al fatto che tutta la fisica si basa sull’idealizzazione di oggetti astratti (pendolo ideale, moto uniforme, massa, ecc.).

Nel senso quotidiano, l’ entropia è il grado di caos e incertezza del sistema: più ordine nel sistema e più i suoi elementi sono subordinati a qualsiasi ordine, minore è l’entropia.

Esempio: un armadio è un sistema specifico. Se in esso tutte le cose sono al loro posto, allora l’entropia è minore. Se tutte le cose sono sparse e non sui loro scaffali, di conseguenza diventa più grande.

La funzione termica dell’entalpia è strettamente correlata a questo termine: caratterizza lo stato di un sistema termodinamico in uno stato di equilibrio quando si sceglie un numero di variabili indipendenti, come la pressione, l’entropia e il numero di particelle.

L’opposto dell’entropia si chiama estropia.

Tipi di entropie

Il termine è usato in termodinamica, economia, teoria dell’informazione e persino sociologia. Cosa definisce in questi ambiti?

In chimica fisica (termodinamica)

Il postulato principale della termodinamica sull’equilibrio: qualsiasi sistema termodinamico isolato arriva a uno stato di equilibrio nel tempo e non può uscirne spontaneamente. Cioè, ogni sistema tende a uno stato di equilibrio per esso. E parlando in termini molto semplici, un tale stato è caratterizzato dal disordine.

Il postulato principale della termodinamica sull’equilibrio: qualsiasi sistema termodinamico isolato arriva a uno stato di equilibrio nel tempo e non può uscirne spontaneamente. Cioè, ogni sistema tende a uno stato di equilibrio per esso. E parlando in termini molto semplici, un tale stato è caratterizzato dal disordine.

L’entropia è una misura del disordine. Come identificare un pasticcio? Un modo è assegnare a ogni stato il numero di opzioni che possono essere utilizzate per implementare quello stato. E più sono queste modalità di implementazione, maggiore è il valore dell’entropia. Più una sostanza è organizzata (la sua struttura), minore è la sua incertezza (casualità).

Il valore assoluto dell’entropia (S ass.) È uguale alla variazione dell’energia disponibile per una sostanza o un sistema durante il trasferimento di calore a una data temperatura. Il suo valore matematico è determinato dal valore del trasferimento di calore (Q) diviso per la temperatura assoluta (T) alla quale avviene il processo: S abs. Q / T. Ciò significa che quando si trasferisce una grande quantità di calore, la S abs. crescerà. Lo stesso effetto sarà osservato per il trasferimento di calore a basse temperature.

In economia

L’economia usa un concetto come il coefficiente di entropia. Con l’aiuto di questo coefficiente, vengono studiati il cambiamento nella concentrazione del mercato e il suo livello. Maggiore è il valore del coefficiente, maggiore è l’incertezza economica e, di conseguenza, diminuisce la probabilità dell’emergere di un monopolio. Il coefficiente aiuta a valutare indirettamente i benefici acquisiti dall’impresa a seguito di possibili attività di monopolio o cambiamenti nella concentrazione del mercato.

In fisica statistica o teoria dell’informazione

L’entropia dell’informazione (incertezza) è una misura dell’imprevedibilità o dell’incertezza di un determinato sistema. Questo valore aiuta a determinare il grado di disturbo nell’esperimento o nell’evento condotto. Maggiore è il numero di stati in cui può trovarsi il sistema, maggiore è il valore dell’incertezza. Tutti i processi di ordinamento del sistema portano all’emergere di informazioni e alla riduzione dell’incertezza delle informazioni.

Con l’aiuto dell’imprevedibilità delle informazioni, è possibile identificare una tale capacità di canale che garantirà una trasmissione affidabile delle informazioni (in un sistema di simboli codificati). E puoi anche prevedere parzialmente il corso dell’esperienza o degli eventi, suddividendoli nelle loro parti componenti e calcolando il valore dell’incertezza per ciascuno di essi. Questo metodo di fisica statistica aiuta a rivelare la probabilità di un evento. Con il suo aiuto, puoi decifrare il testo codificato analizzando la probabilità di comparsa dei simboli e il loro indice di entropia.

Esiste una cosa come l’entropia assoluta di una lingua. Questo valore esprime la quantità massima di informazioni che può essere trasmessa in un’unità di questa lingua. In questo caso, il simbolo dell’alfabeto della lingua (bit) viene preso come unità.

In sociologia

Qui l’entropia (incertezza dell’informazione) è una caratteristica della deviazione della società (sistema) o dei suoi collegamenti dallo stato accettato (di riferimento), e questo si manifesta in una diminuzione dell’efficienza dello sviluppo e del funzionamento del sistema, deterioramento del sé -organizzazione. Un semplice esempio: i dipendenti di un’azienda sono così carichi di lavoro (eseguendo un gran numero di rapporti) che non hanno il tempo di impegnarsi nella loro attività principale (eseguire controlli). In questo esempio, la misura dell’uso inappropriato delle risorse di lavoro da parte della direzione sarà l’incertezza delle informazioni.

Come si manifesta l’entropia nelle nostre vite

Con l’aiuto dell’entropia, puoi spiegare molti fatti incomprensibili e sorprendenti, ad esempio:

Perché la nostra vita è così straordinaria

Immagina il corpo umano. Gli atomi che compongono il corpo avrebbero potuto piegarsi in un numero quasi infinito di varianti e non creare alcuna forma di vita. Dal punto di vista della matematica, la probabilità della nostra esistenza è molto piccola. Eppure noi esistiamo.

In un universo in cui l’entropia governa tutto, l’esistenza della vita con un’organizzazione così chiara e stabile è sorprendente.

Perché amiamo l’arte e la bellezza

L’entropia può spiegare perché l’arte e la bellezza ci sembrano così esteticamente piacevoli. L’artista crea una forma speciale di ordine e simmetria che molto probabilmente l’Universo non avrebbe mai generato da solo. Il numero di bellissime combinazioni è molto inferiore al numero totale di tutte le combinazioni. La bellezza è una rarità in un universo pieno di disordine. Pertanto, una faccia simmetrica è rara e bella, perché ci sono opzioni incomparabilmente più asimmetriche.

Perché hai bisogno di creare le condizioni ideali per te stesso?

Ognuno di noi ha i propri talenti, capacità e interessi. Ma la società e la cultura in cui viviamo non sono state create appositamente per noi. Con l’entropia in mente, considera quali sono le possibilità che l’ambiente in cui sei cresciuto sia l’ideale per liberare i tuoi talenti?

È estremamente improbabile che la vita crei per te una situazione che si adatti perfettamente alle tue capacità. Molto probabilmente, ti troverai in una posizione che non corrisponde esattamente alle tue capacità e ai tuoi bisogni.

Di solito descriviamo uno stato di questo tipo come “fuori luogo”, “fuori dal loro elemento”. Naturalmente, in tali condizioni è molto più difficile raggiungere il successo, essere utili, vincere. Sapendo questo, dobbiamo creare noi stessi condizioni di vita ideali per noi stessi.Le difficoltà nella vita non sorgono perché i pianeti sono così allineati, e non perché alcuni poteri superiori hanno cospirato contro di te. È solo la legge dell’entropia al lavoro. Ci sono molti più stati di disordine di quelli ordinati. Con tutto questo in mente, non sorprende che ci siano problemi nella vita, ma che possiamo risolverli.

Equazione e calcolo dell’entropia

Esistono diversi modi per calcolare l’entropia. Ma le due equazioni più comuni si riferiscono a processi termodinamici e isotermici reversibili (con temperatura costante).

Entropia e morte termica dell’universo

Alcuni scienziati prevedono che l’entropia dell’universo aumenterà a tal punto da creare un sistema incapace di un lavoro utile. E rimarrà solo l’energia termica. L’universo, dicono, morirà di morte termica.

Tuttavia, altri scienziati contestano la teoria della morte per calore. Sostengono che l’universo come sistema si sta allontanando sempre di più dall’entropia. Anche se l’entropia all’interno di alcune delle sue regioni interne

aumenta.

Altri vedono l’universo come parte di un sistema ancora più grande. Altri ancora dicono che gli stati possibili non hanno la stessa probabilità. Pertanto, le solite equazioni per il calcolo dell’entropia sono irrilevanti.

Le più comuni formulazioni di entropia in fisica

Molti fisici famosi hanno cercato di spiegare il concetto di entropia in modo accessibile alla gente comune. Evidenziamo le 3 formulazioni più famose della spiegazione.

La dichiarazione di Clausius

Il riscaldamento di un corpo con una temperatura più alta non è possibile con un corpo con una temperatura più bassa.

Ad esempio, assomiglia a questo: puoi mettere un bollitore con acqua su un pezzo di ghiaccio (a priori, la temperatura dell’acqua è più alta della temperatura del ghiaccio), ma non puoi aspettare che l’acqua bolle. Sebbene i primi 2 inizi della termodinamica non negano questa possibilità.

Formulazione di Thomson

In un sistema chiuso, un processo è impossibile, il cui unico risultato sarebbe il lavoro svolto a causa dell’energia termica ricevuta da qualsiasi corpo.

La dichiarazione di Boltzmann

Una diminuzione dell’entropia in un sistema chiuso è impossibile.

Questa formulazione causa molte controversie, sebbene tutto sia intuitivamente chiaro. Il caos crescerà in un’abitazione abbandonata: la polvere si depositerà, alcune cose andranno in pezzi. Puoi mettere le cose in ordine, ma solo applicando energia esterna, cioè il lavoro di un addetto alle pulizie.

Il problema è che l’Universo nei concetti moderni è un sistema chiuso. Si è formato da qualche parte 14-15 miliardi di anni fa. Durante questo periodo, la sua entropia avrebbe portato al fatto che le galassie si sarebbero disintegrate, le stelle si sarebbero spente e in linea di principio non sarebbero apparse nuove stelle. Ma il nostro Sole non ha più di 5 miliardi di anni e l’Universo nel suo insieme non è entrato in uno stato di caos.

Entropia: tesi ed esempi

Un esempio. Programma T9. Se una parola contiene un numero limitato di errori di battitura, il programma riconoscerà facilmente la parola e ne suggerirà la sostituzione. Più errori di battitura, meno informazioni il programma avrà sulla parola inserita. Di conseguenza, un aumento della confusione porterà ad un aumento dell’incertezza delle informazioni e viceversa, maggiore è la quantità di informazioni, minore è l’incertezza.

Esempio. Dado. C’è solo un modo per eliminare una combinazione di 12 o 2: 1 più 1 o 6 più 6. E il numero massimo di modi è 7 (ha 6 combinazioni possibili). L’imprevedibilità dell’implementazione del numero sette è massima in questo caso.

- In senso generale, l’entropia (S) può essere intesa come una misura della distribuzione di energia. A un valore basso di S, l’energia è concentrata e ad un valore alto viene distribuita in modo caotico.

Esempio. L’H2O (noto a tutta l’acqua) nel suo stato liquido di aggregazione avrà una maggiore entropia rispetto al solido (ghiaccio). Perché in un solido cristallino, ogni atomo occupa una certa posizione nel reticolo cristallino (ordine) e, allo stato liquido, gli atomi non hanno determinate posizioni fisse (disordine). Cioè, un corpo con una disposizione più rigida di atomi ha un valore di entropia inferiore (S). Il diamante bianco senza impurità ha il valore S più basso rispetto ad altri cristalli.

Esempio. La molecola si trova in un vaso che ha un lato sinistro e uno destro. Se non è noto in quale parte del vaso si trova la molecola, allora l’entropia (S) sarà determinata dalla formula S = S max = k lgW, dove k è il numero di metodi di implementazione, W è il numero di parti della nave. L’informazione in questo caso sarà uguale a zero I = I min = 0. Se si sa esattamente in quale parte del vaso si trova la molecola, allora S = S min = k ln1 = 0 e I = I max = log 2 W. Pertanto, maggiore è la quantità di informazioni, minore è il valore dell’incertezza dell’informazione .

Esempio. Più alto è l’ordine sul desktop, più informazioni puoi apprendere sulle cose che si trovano su di esso. In questo caso, l’ordine degli oggetti riduce l’entropia del sistema “desktop”.

Esempio. Ci sono più informazioni sulla classe durante la lezione che durante la pausa. L’entropia nella lezione è di seguito, poiché gli studenti sono seduti in modo ordinato (maggiori informazioni sulla posizione di ogni studente). E durante le pause, la disposizione degli studenti cambia in modo caotico, il che aumenta la loro entropia.

Esempio. Quando un metallo alcalino reagisce con l’acqua, viene rilasciato idrogeno. L’idrogeno è un gas. Poiché le molecole di gas si muovono in modo caotico e hanno un’entropia elevata, la reazione in esame avviene con un aumento del suo valore.

Dalla vita di tutti i giorni:

- Quando scriviamo messaggi sms su un telefono cellulare, usiamo spesso il programma T9. Meno errori nella parola che stiamo digitando, più facile sarà riconoscerla dal programma e più velocemente ci offrirà la sua sostituzione. Conclusione: maggiore è la confusione, maggiore è l’incertezza delle informazioni.

- Quando tiriamo due dadi quando giociamo a dadi, c’è solo un modo per tirare una combinazione di 2 o 12 (1 e 1, 6 e 6). Il numero massimo di modi per distribuire il numero 7 (6 possibili combinazioni). L’imprevedibilità in questo caso sarà massima.

- Ci sono più informazioni sul numero di studenti durante la lezione che durante la pausa. Poiché nella lezione ogni studente si siede al suo posto, l’entropia è inferiore. Fuori dall’aula, il movimento degli scolari è caratterizzato dal caos, che porta ad un aumento del valore dell’entropia.

- Se pulisci la scrivania, metti gli oggetti al loro posto, puoi ottenere maggiori informazioni su questo o quell’oggetto su di esso. L’ordine delle cose sulla scrivania riduce la quantità di entropia.

Importante! Tutto ciò che ci circonda tende ad aumentare l’entropia. Una persona intende ricevere la massima quantità di informazioni dal mondo che la circonda. Tutte le direzioni teoriche nello studio dell’entropia (in fisica, chimica, economia, matematica, sociologia) sono finalizzate a stabilire un equilibrio (equilibrio) tra le intenzioni e i desideri delle persone ei processi naturali che avvengono in natura.

Entropia: cos’è in parole semplici

La lingua russa, come qualsiasi altra, cambia costantemente sotto la pressione del costante prestito tecnologico e della cooperazione con altri stati. Grazie a ciò, la nostra lingua è ricca di vari prestiti in lingue straniere.

Una delle parole relativamente nuove in lingua russa era la parola “entropia”, che è stata incontrata da molti di noi, ma non tutti capiscono cosa significhi veramente.

Cos’è l’entropia in parole semplici

Il più delle volte, la parola “entropia” si trova, ovviamente, nella fisica classica. Questo è uno dei concetti più difficili di questa scienza, quindi, anche gli studenti delle università di fisica spesso affrontano problemi nella percezione di questo termine.

Questa è una coordinata molto specifica – la capitale della Federazione Russa – tuttavia, Mosca è una città piuttosto grande, quindi non conosci ancora le informazioni esatte sulla mia posizione. Ma quando ti dico, ad esempio, il mio codice postale, l’entropia su di me, come oggetto, diminuirà.

Questa non è un’analogia del tutto accurata, quindi diamo un altro esempio per chiarire. Diciamo che prendiamo dieci dadi a sei facce. Mettiamoli tutti a turno, e poi ti dirò il totale degli indicatori caduti – trenta.

Sulla base della somma di tutti i risultati, non sarai in grado di dire con certezza quale cifra e su quale dado è caduto – semplicemente non hai dati sufficienti per questo. Nel nostro caso, ogni cifra abbandonata nel linguaggio dei fisici sarà chiamata microstato e una quantità pari a trenta, nello stesso dialetto fisico, sarà chiamata macrostato.

Se calcoliamo quanti possibili microstati tre dozzine possono darci in totale, arriviamo alla conclusione che il loro numero raggiunge quasi tre milioni di valori. Usando una formula speciale, possiamo calcolare l’indice di entropia in questo esperimento probabilistico: sei e mezzo.

Da dove viene la metà, potresti chiedere? Questa parte frazionaria appare dovuta al fatto che quando si numerano nel settimo ordine, possiamo operare con solo tre numeri: 0, 1 e 2.

La parola moderna “entropia” ha radici greche, quindi, a causa della traduzione, è spesso chiamata “misura del caos”. Diciamo che decidi di fare una festa nel tuo appartamento in occasione del compleanno di tua figlia.

Hanno pulito l’intero appartamento, hanno lavato i pavimenti e le finestre, hanno lavato i piatti e poi hanno disposto tutti i piatti in modo bello ed elegante sul tavolo. Il caos domestico iniziale del tuo appartamento è notevolmente diminuito, quindi la tua casa è diventata un sistema con bassa entropia.

Entropia nell’universo

Secondo le previsioni degli astrofisici, una delle opzioni per lo sviluppo dell’Universo è la morte per calore.

Il nostro universo è (immaginate quanto lungimiranti erano gli antichi greci a questo proposito) puro caos, in cui qualcosa accade costantemente: le stelle nascono e muoiono, si formano nuove galassie, insomma bellezza! Ad un certo punto, l’entropia dell’Universo raggiungerà il suo massimo e semplicemente non accadrà nulla in esso. Questo per quanto riguarda la morte per ozio.

Il caos permea l’intero cosmo, tutta la nostra natura, fino agli atomi e alle particelle elementari. Tutto è in costante movimento e interazione, come un meccanismo perfettamente funzionante. E tutti questi processi sono governati da leggi che noi, miserabili, possiamo esprimere in un linguaggio matematico non meno bello.

Ma come, con un tale livello di entropia (cioè caos) nell’Universo, sarebbe potuto sorgere qualcosa? La risposta a questa domanda è estremamente semplice. Tutta la materia trasferisce il livello della sua entropia al proprio ambiente, tutto ciò che può raggiungere.

Ad esempio, per regolare il livello di entropia sulla Terra, una stella chiamata Sole ci fornisce costantemente energia, che produce a causa di una reazione termonucleare incessante sulla sua superficie.

Se il nostro pianeta fosse un sistema chiuso, allora, secondo la seconda legge della termodinamica, l’entropia al suo interno potrebbe solo aumentare, ma, come avete già capito, il Sole ci permette di mantenere normale il livello di entropia terrestre.

Entropia e caos permeano tutto ciò che ci circonda e anche ciò che è dentro di noi. Nei gas e nei liquidi, l’entropia gioca un ruolo chiave, anche i nostri desideri e impulsi momentanei non sono in realtà altro che un prodotto del caos universale universale.

Non è difficile giungere ancora una volta alla conclusione più bella: l’Universo, per quanto enorme possa essere, è un insieme di un numero infinito di particelle delle dimensioni più diverse e con proprietà non meno diverse.

Tutto in esso, da un bosone elementare ad Alpha Centauri e intere galassie, è collegato da fili invisibili. Tali scoperte dei fisici colpiscono non solo per la loro complessità, ma anche per la loro bellezza.

Sembrerebbe che le solite formule matematiche e fisiche sulle tavole di uomini pensosi con la barba lunga e con gli occhiali siano fattori chiave per la nostra conoscenza di noi stessi, di noi stessi e del nostro posto nel vasto Universo.

Ci auguriamo che questo articolo ti abbia aiutato a chiarire cos’è veramente l’entropia, in quali casi viene usata questa parola e anche a cosa ha portato la scoperta di questo indicatore a scienziati e filosofi.

Chissà, forse leggere questo articolo ti ispirerà a studiare intenzionalmente questa meravigliosa scienza: la fisica. In un modo o nell’altro, è di vitale importanza per una persona moderna interessarsi alla scienza, almeno per il proprio sviluppo.

Finalmente

Se combiniamo tutto quanto sopra, risulta che l’entropia è una misura del disordine o dell’incertezza del sistema e delle sue parti. Un fatto interessante è che tutto in natura tende alla massima entropia, e l’uomo – alla massima informazione.

Fonti utilizzate e link utili sull’argomento: https://advi.club/psihologiya-i-obshhestvo/183-entropiya-prostymi-slovami.html https://obraz-ola.ru/prochee/razbiraemsya-chto-takoe- entropiya .html https://tvercult.ru/nauka/entropiya-chto-eto-takoe-obyasnenie-termina-prostyimi-slovami https://Lifehacker.ru/entropy/ https://zen.yandex.ru/media/ alivespace / chto-takoe-entropiia-5d98e1ab43863f00b19f8f80 https://zen.yandex.ru/media/popsci/chto-takoe-entropiia-i-kak-ona-sviazana-s-materiei-i-energiei-5c55ad170280urued00ae . / nauka / entropiya-chto-eto-takoe-obyasnenie-termina-prostymi-slovami.html