Definición

La entropía (traducida del griego antiguo – giro, transformación) es una medida, el grado de desorden (caos) de cualquier sistema. Utilizado en las siguientes ciencias exactas y naturales:

- En matemáticas, significa encontrar el logaritmo del número de estados disponibles del sistema;

- En ciencia estadística, el valor probabilístico del inicio de cualquier estado macroscópico del sistema;

- En termodinámica (física), el grado de difusión irreversible de energía, es decir el valor estándar de sus pérdidas, que son inevitables cuando un cuerpo más caliente interactúa con uno más frío;

- En informática, significa la capacidad de información del sistema. Un hecho interesante es el siguiente: Claude Shannon (el fundador de este término en la teoría de la información) originalmente pensó en llamar información a la entropía.

Casi complicado

La entropía es un concepto que se utiliza en más de un área de la actividad humana, por lo que sus definiciones pueden ser algo vagas. Este término refleja un valor y su esencia se puede desmontar con ejemplos sencillos. La entropía es el grado de desorden, el grado de incertidumbre y desorden.

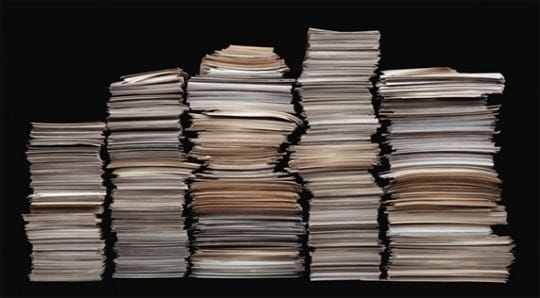

La alta entropía se puede visualizar como una calle con trozos de papel esparcidos. Si los papeles se apilan ordenadamente en una pila, entonces el sistema está ordenado y la entropía es baja. Es necesario reducir los valores de entropía y, para ello, es necesario dedicar mucho tiempo a pegar los papeles pieza por pieza y apilarlos.

Si tiene lugar la entropía de un sistema cerrado, entonces todo también es simple aquí. Un sistema cerrado se puede imaginar como un armario cerrado, si las cosas están esparcidas en él, entonces es imposible influir en ellas desde el exterior y el caos en el armario estará presente durante mucho tiempo.

Con el tiempo, las cosas se descompondrán y esto conducirá al orden, pero las cosas deben descomponerse durante mucho tiempo, por ejemplo, se necesitan 5 años para un calcetín de lana y unos 40 años para los zapatos de cuero. En este ejemplo, el armario actúa como un sistema aislado, y la descomposición de las cosas en él es poner las cosas en orden en las estructuras.

El mínimo es la entropía, que se refiere a los objetos macroscópicos, se pueden observar a simple vista. En cuanto a los indicadores más altos, a menudo tienen un vacío.

Historia de origen

Por primera vez, el concepto de entropía se introdujo en la era del desarrollo de la termodinámica, cuando surgió la necesidad de estudiar los procesos que ocurren dentro de los cuerpos termodinámicos. En 1865, un físico de Alemania, Rudolf Clausius, describió con este término el estado del sistema en el que el calor tiene la capacidad de transformarse en otros tipos de energía (mecánica, química, luminosa, etc.).

El aumento de entropía es causado por el influjo de energía térmica en el sistema y está asociado con la temperatura a la que se produce este influjo. La necesidad de este valor se debió al hecho de que toda la física se basa en la idealización de objetos abstractos (péndulo ideal, movimiento uniforme, masa, etc.).

En el sentido cotidiano, la entropía es el grado de caos e incertidumbre del sistema: cuanto más orden hay en el sistema y más subordinados están sus elementos a cualquier orden, menos entropía.

Ejemplo: un armario es un sistema específico. Si en él todas las cosas están en su lugar, entonces la entropía es menor. Si todas las cosas están dispersas y no en sus estantes, entonces se vuelve más grande.

La función térmica de la entalpía está estrechamente relacionada con este término: caracteriza el estado de un sistema termodinámico en un estado de equilibrio al elegir una serie de variables independientes, como la presión, la entropía y el número de partículas.

Lo opuesto a la entropía se llama extropía.

Tipos de entropías

El término se usa en termodinámica, economía, teoría de la información e incluso sociología. ¿Qué define en estas áreas?

En química física (termodinámica)

El principal postulado de la termodinámica sobre el equilibrio: cualquier sistema termodinámico aislado llega a un estado de equilibrio con el tiempo y no puede salir de él espontáneamente. Es decir, cada sistema se esfuerza por lograr un estado de equilibrio para él. Y hablando en términos muy simples, tal estado se caracteriza por el desorden.

El principal postulado de la termodinámica sobre el equilibrio: cualquier sistema termodinámico aislado llega a un estado de equilibrio con el tiempo y no puede salir de él espontáneamente. Es decir, cada sistema se esfuerza por lograr un estado de equilibrio para él. Y hablando en términos muy simples, tal estado se caracteriza por el desorden.

La entropía es una medida de desorden. ¿Cómo identificas un desastre? Una forma es asignar a cada estado el número de opciones con las que se puede realizar ese estado. Y cuantas más formas de implementación sean, mayor será el valor de la entropía. Cuanto más organizada es una sustancia (su estructura), menor es su incertidumbre (aleatoriedad).

El valor absoluto de la entropía (S abs.) Es igual al cambio en la energía disponible para una sustancia o sistema durante la transferencia de calor a una temperatura dada. Su valor matemático se determina a partir del valor de la transferencia de calor (Q) dividido por la temperatura absoluta (T) a la que tiene lugar el proceso: S abs. Q / T. Esto significa que al transferir una gran cantidad de calor, el S abs. incrementará. El mismo efecto se observará con la transferencia de calor a bajas temperaturas.

En economia

La economía usa un concepto como el coeficiente de entropía. Con la ayuda de este coeficiente, se investiga el cambio en la concentración del mercado y su nivel. Cuanto mayor es el valor del coeficiente, mayor es la incertidumbre económica y, en consecuencia, la probabilidad de que surja un monopolio disminuye. El coeficiente ayuda a evaluar indirectamente los beneficios adquiridos por la empresa como resultado de posibles actividades de monopolio o cambios en la concentración del mercado.

En física estadística o teoría de la información

La entropía de la información (incertidumbre) es una medida de la imprevisibilidad o incertidumbre de un determinado sistema. Este valor ayuda a determinar el grado de aleatoriedad del experimento o evento que se está realizando. Cuanto mayor sea el número de estados en los que puede estar el sistema, mayor será el valor de la incertidumbre. Todos los procesos de ordenación del sistema conducen a la aparición de información y a la reducción de la incertidumbre de la información.

Con la ayuda de la imprevisibilidad de la información, es posible identificar tal capacidad de canal que asegurará una transmisión confiable de información (en un sistema de símbolos codificados). Y también puede predecir parcialmente el curso de la experiencia o los eventos, dividiéndolos en sus partes componentes y calculando el valor de incertidumbre para cada uno de ellos. Este método de física estadística ayuda a revelar la probabilidad de un evento. Con su ayuda, puede descifrar el texto codificado analizando la probabilidad de aparición de símbolos y su índice de entropía.

Existe la entropía absoluta de una lengua. Este valor expresa la cantidad máxima de información que se puede transmitir en una unidad de este idioma. En este caso, el símbolo del alfabeto del idioma (bit) se toma como una unidad.

En sociología

Aquí la entropía (incertidumbre de la información) es una característica de la desviación de la sociedad (sistema) o sus vínculos del estado aceptado (referencia), y esto se manifiesta en una disminución en la eficiencia del desarrollo y funcionamiento del sistema, deterioro de uno mismo. -organización. Un ejemplo simple: los empleados de una empresa están tan cargados de trabajo (realizando una gran cantidad de informes) que no tienen tiempo para dedicarse a su actividad principal (realizar controles). En este ejemplo, la medida del uso inadecuado de los recursos de trabajo por parte de la gerencia será la incertidumbre de la información.

Cómo se manifiesta la entropía en nuestras vidas

Con la ayuda de la entropía, puede explicar muchos hechos incomprensibles y sorprendentes, por ejemplo:

¿Por qué nuestra vida es tan extraordinaria?

Imagina el cuerpo humano. Los átomos que componen el cuerpo podrían haberse plegado en un número casi infinito de variantes y no crear ninguna forma de vida. Desde el punto de vista de las matemáticas, la probabilidad de nuestra existencia es muy pequeña. Y sin embargo existimos.

En un universo donde la entropía lo gobierna todo, la existencia de vida con una organización tan clara y estable es asombrosa.

Por qué amamos el arte y la belleza

La entropía puede explicar por qué el arte y la belleza nos parecen tan agradables estéticamente. El artista crea una forma especial de orden y simetría que el Universo probablemente nunca habría generado por sí solo. El número de hermosas combinaciones es mucho menor que el número total de todas las combinaciones. La belleza es una rareza en un universo lleno de desorden. Por lo tanto, una cara simétrica es rara y hermosa, porque hay opciones incomparablemente más asimétricas.

Por qué no se deben encontrar las condiciones ideales para usted, sino crearlas.

Cada uno de nosotros tiene sus propios talentos, habilidades e intereses. Pero la sociedad y la cultura en la que vivimos no fueron creadas específicamente para nosotros. Con la entropía en mente, considere cuáles son las posibilidades de que el entorno en el que creció sea ideal para dar rienda suelta a sus talentos.

Es muy poco probable que la vida te cree una situación que se adapte perfectamente a tus habilidades. Lo más probable es que se encuentre en una posición que no se corresponda con sus habilidades y necesidades.

Por lo general, describimos un estado como “fuera de lugar”, “fuera de su elemento”. Naturalmente, en tales condiciones es mucho más difícil lograr el éxito, ser útil, ganar. Sabiendo esto, debemos crear nosotros mismos las condiciones de vida ideales para nosotros mismos Las dificultades en la vida surgen no porque los planetas estén alineados de esa manera, ni porque algunas fuerzas superiores hayan conspirado contra ti. Es solo la ley de la entropía en funcionamiento. Hay muchos más estados de desorden que ordenados. Con todo esto en mente, no es de extrañar que haya problemas en la vida, pero que podamos solucionarlos.

Ecuación y cálculo de entropía

Hay varias formas de calcular la entropía. Pero las dos ecuaciones más comunes se relacionan con procesos termodinámicos e isotermos reversibles (con temperatura constante).

Entropía y muerte por calor del universo.

Algunos científicos predicen que la entropía del universo aumentará hasta tal punto que crea un sistema que es incapaz de realizar un trabajo útil. Y solo quedará energía térmica. El universo, dicen, morirá de muerte por calor.

Sin embargo, otros científicos cuestionan la teoría de la muerte por calor. Argumentan que el universo como sistema se está alejando cada vez más de la entropía. Incluso si

aumenta la entropía dentro de algunas de sus regiones internas .

Otros ven el universo como parte de un sistema aún mayor. Otros dicen que los estados posibles no tienen la misma probabilidad. Por tanto, las ecuaciones habituales para calcular la entropía son irrelevantes.

Las formulaciones de entropía más comunes en física.

Muchos físicos famosos han intentado explicar el concepto de entropía de una manera accesible para la gente común. Destaquemos las 3 formulaciones más famosas de la explicación.

Declaración de Clausius

Calentar un cuerpo con una temperatura más alta no es posible con un cuerpo con una temperatura más baja.

Por ejemplo, se ve así: puede poner una tetera con agua en un trozo de hielo (a priori, la temperatura del agua es más alta que la temperatura del hielo), pero no puede esperar a que el agua hierva. Aunque los 2 primeros inicios de la termodinámica no niegan esta posibilidad.

Formulación de Thomson

En un sistema cerrado, un proceso es imposible, cuyo único resultado sería el trabajo realizado debido a la energía térmica recibida de cualquier cuerpo.

Declaración de Boltzmann

Es imposible una disminución de la entropía en un sistema cerrado.

Esta redacción provoca mucha polémica, aunque todo es intuitivamente claro. El caos crecerá en una vivienda abandonada: el polvo se asentará, algunas cosas se desmoronarán. Puedes poner las cosas en orden, pero solo aplicando energía externa, es decir, el trabajo de un limpiador.

El problema es que el Universo en conceptos modernos es un sistema cerrado. Se formó en algún lugar hace 14-15 mil millones de años. Durante este tiempo, su entropía llevaría a que las galaxias se desintegraran, las estrellas se apagaran y en principio no aparecerían nuevas estrellas. Pero nuestro Sol no tiene más de 5 mil millones de años y el Universo en su conjunto no ha entrado en un estado de caos.

Entropía: tesis y ejemplos

Un ejemplo. Programa T9. Si una palabra contiene una pequeña cantidad de errores tipográficos, el programa reconocerá fácilmente la palabra y sugerirá su reemplazo. Cuantos más errores tipográficos, menos información tendrá el programa sobre la palabra que se ingresa. En consecuencia, un aumento de la confusión conducirá a un aumento de la incertidumbre de la información y, a la inversa, a más información, menos incertidumbre.

Ejemplo. Dado. Solo hay una forma de descartar una combinación de 12 o 2: 1 más 1 o 6 más 6. Y el número máximo de formas es 7 (tiene 6 combinaciones posibles). La imprevisibilidad de la implementación del número siete es mayor en este caso.

- En un sentido general, la entropía (S) puede entenderse como una medida de distribución de energía. A un valor bajo de S, la energía se concentra y a un valor alto, se distribuye caóticamente.

Ejemplo. El H2O (conocido por toda el agua) en su estado líquido de agregación tendrá mayor entropía que en el sólido (hielo). Porque en un sólido cristalino, cada átomo ocupa una determinada posición en la red cristalina (orden), y en estado líquido, los átomos no tienen determinadas posiciones fijas (desorden). Es decir, un cuerpo con una disposición más rígida de átomos tiene un valor de entropía más bajo (S). El diamante blanco sin impurezas tiene el valor S más bajo en comparación con otros cristales.

Ejemplo. La molécula está en un recipiente que tiene un lado izquierdo y otro derecho. Si no se sabe en qué parte del recipiente se encuentra la molécula, entonces la entropía (S) se determinará mediante la fórmula S = S max = k lgW, donde k es el número de métodos de implementación, W es el número de partes del recipiente. La información en este caso será igual a cero I = I min = 0. Si se sabe exactamente en qué parte del recipiente se encuentra la molécula, entonces S = S min = k ln1 = 0, e I = I max = log 2 W.Por lo tanto, cuanto más información, menor es el valor de la incertidumbre de la información. .

Ejemplo. Cuanto mayor sea el orden en el escritorio, más información podrá obtener sobre las cosas que contiene. En este caso, el orden de los objetos reduce la entropía del sistema de “escritorio”.

Ejemplo. Hay más información sobre la clase durante la lección que durante el receso. La entropía de la lección se muestra a continuación, ya que los estudiantes están sentados de manera ordenada (más información sobre la ubicación de cada estudiante). Y durante los descansos, la disposición de los estudiantes cambia caóticamente, lo que aumenta su entropía.

Ejemplo. Cuando un metal alcalino reacciona con el agua, se libera hidrógeno. El hidrógeno es un gas. Dado que las moléculas de gas se mueven caóticamente y tienen alta entropía, la reacción en consideración ocurre con un aumento en su valor.

De la vida cotidiana:

- Al escribir mensajes sms en un teléfono móvil, a menudo usamos el programa T9. Cuantos menos errores en la palabra que estemos escribiendo, más fácil será reconocerla por el programa y más rápido nos ofrecerá su reemplazo. Conclusión: a mayor confusión, mayor incertidumbre en la información.

- Cuando tiramos dos dados cuando jugamos a los dados, solo hay una forma de lanzar una combinación de 2 o 12 (1 y 1, 6 y 6). El número máximo de formas de desplegar el número 7 (6 combinaciones posibles). La imprevisibilidad en este caso será máxima.

- Hay más información sobre el número de alumnos durante la lección que durante el receso. Dado que en la lección cada alumno se sienta en su lugar, la entropía es menor. Fuera del aula, el movimiento de los escolares se caracteriza por el caos, lo que conduce a un aumento del valor de la entropía.

- Si limpia el escritorio de trabajo, coloca los objetos en su lugar, entonces puede obtener más información sobre este o aquel objeto. El orden de las cosas en el escritorio reduce la cantidad de entropía.

¡Importante! Todo lo que nos rodea tiende a aumentar la entropía. Una persona tiene la intención de recibir la máxima cantidad de información del mundo que la rodea. Todas las direcciones teóricas en el estudio de la entropía (en física, química, economía, matemáticas, sociología) tienen como objetivo establecer un equilibrio (equilibrio) entre las intenciones y deseos de las personas y los procesos naturales que ocurren en la naturaleza.

Entropía: ¿qué es en palabras simples?

El idioma ruso, como cualquier otro, cambia constantemente bajo la presión de los préstamos tecnológicos constantes y la cooperación con otros estados. Gracias a esto, nuestro idioma es rico en varios préstamos de idiomas extranjeros.

Una de las palabras relativamente nuevas en el idioma ruso fue la palabra “entropía”, que fue encontrada por muchos de nosotros, pero no todos entienden lo que realmente significa.

¿Qué es la entropía en palabras simples?

Muy a menudo, la palabra “entropía” se encuentra, por supuesto, en la física clásica. Este es uno de los conceptos más difíciles de esta ciencia, por lo tanto, incluso los estudiantes de las universidades de física suelen enfrentar problemas en la percepción de este término.

Esta es una coordenada muy específica, la capital de la Federación de Rusia, sin embargo, Moscú es una ciudad bastante grande, por lo que aún no conoce la información exacta sobre mi ubicación. Pero cuando les digo mi, por ejemplo, código postal, la entropía sobre mí, como objeto, disminuirá.

Esta no es una analogía del todo precisa, por lo que daremos un ejemplo más para aclarar. Digamos que tomamos diez dados de seis caras. Vamos a lanzarlos todos a su vez, y luego les diré el total de los indicadores caídos: treinta.

Basándose en la suma de todos los resultados, no podrá decir con certeza qué cifra y en qué dado se cayó, simplemente no tiene suficientes datos para esto. En nuestro caso, cada dígito eliminado en el lenguaje de los físicos se llamará microestado, y una cantidad igual a treinta, en el mismo dialecto físico, se llamará macroestado.

Si calculamos cuántos microestados posibles nos pueden dar tres docenas en total, llegamos a la conclusión de que su número alcanza casi los tres millones de valores. Usando una fórmula especial, podemos calcular el índice de entropía en este experimento probabilístico: seis y medio.

¿De dónde vino la mitad, podrías preguntar? Esta parte fraccionaria aparece debido al hecho de que al numerar en el séptimo orden, podemos operar con solo tres números: 0, 1 y 2.

La palabra moderna “entropía” tiene raíces griegas, por lo tanto, debido a la traducción, a menudo se la llama “medida del caos”. Digamos que decides hacer una fiesta en tu apartamento con motivo del cumpleaños de tu pequeña hija.

Limpiaron todo el apartamento, lavaron los pisos y las ventanas, lavaron los platos y luego colocaron todos los platos de manera hermosa y elegante sobre la mesa. El caos doméstico inicial de su apartamento ha disminuido significativamente, por lo tanto, su casa se ha convertido en un sistema con baja entropía.

Entropía en el Universo

Según las previsiones de los astrofísicos, una de las opciones para el desarrollo del Universo es la muerte por calor.

Nuestro universo es (imagínense cuán previsores eran los antiguos griegos a este respecto) puro caos, en el que algo está sucediendo constantemente: las estrellas nacen y mueren, se forman nuevas galaxias, en resumen, ¡belleza! En un buen momento, la entropía del Universo alcanzará su máximo y simplemente no habrá nada que suceda en él. Hasta aquí la muerte por ociosidad.

El caos impregna todo el cosmos, toda nuestra naturaleza, hasta los átomos y las partículas elementales. Todo está en constante movimiento e interacción, como un mecanismo perfectamente trabajado. Y todos estos procesos están regidos por leyes que nosotros, miserables, podemos expresar en un lenguaje matemático no menos bello.

Pero, ¿cómo, con tal nivel de entropía (es decir, caos) en el Universo, podría surgir algo? La respuesta a esta pregunta es extremadamente simple. Toda materia transfiere el nivel de su entropía a su propio entorno, todo lo que puede alcanzar.

Por ejemplo, para regular el nivel de entropía en la Tierra, una estrella llamada Sol nos suministra constantemente energía, que produce debido a una incesante reacción termonuclear en su superficie.

Si nuestro planeta fuera un sistema cerrado, entonces, de acuerdo con la segunda ley de la termodinámica, la entropía en su interior solo podría aumentar, pero, como ya entendiste, el Sol nos permite mantener el nivel de entropía de la Tierra normal.

La entropía y el caos impregnan todo lo que nos rodea e incluso lo que hay dentro de nosotros. En gases y líquidos, la entropía juega un papel clave, incluso nuestros deseos e impulsos momentáneos no son más que un producto del caos universal universal.

No es difícil llegar una vez más a la conclusión más hermosa: el Universo, por grande que sea, es una colección de un número infinito de partículas de los más diversos tamaños y propiedades no menos diversas.

Todo en él, desde un bosón elemental hasta Alpha Centauri y galaxias enteras, está conectado por hilos invisibles. Tales descubrimientos de los físicos son sorprendentes no solo por su complejidad, sino también por su belleza.

Parecería que las fórmulas matemáticas y físicas habituales en los tableros de hombres pensativos sin afeitar con gafas son factores clave para nuestro conocimiento de nosotros mismos y de nosotros mismos y nuestro lugar en el vasto Universo.

Esperamos que este artículo te haya ayudado a aclarar qué es realmente la entropía, en qué casos se usa esta palabra y también a qué llevó el descubrimiento de este indicador a científicos y filósofos.

Quién sabe, tal vez leer este artículo lo inspire a estudiar a propósito esta maravillosa ciencia: la física. De una forma u otra, es de vital importancia que una persona moderna se interese por la ciencia, al menos para su propio desarrollo.

Finalmente

Si combinamos todo lo anterior, resulta que la entropía es una medida del desorden o incertidumbre del sistema y sus partes. Un hecho interesante es que todo en la naturaleza tiende a la máxima entropía, y el hombre, a la máxima información.

Fuentes utilizadas y enlaces útiles sobre el tema: https://advi.club/psihologiya-i-obshhestvo/183-entropiya-prostymi-slovami.html https://obraz-ola.ru/prochee/razbiraemsya-chto-takoe- entropiya .html https://tvercult.ru/nauka/entropiya-chto-eto-takoe-obyasnenie-termina-prostyimi-slovami https://Lifehacker.ru/entropy/ https://zen.yandex.ru/media/ alivespace / chto-takoe-entropiia-5d98e1ab43863f00b19f8f80 https://zen.yandex.ru/media/popsci/chto-takoe-entropiia-i-kak-ona-sviazana-s-materiei-i-energiei-5c55ad170280ed00ae . obra / nauka / entropiya-chto-eto-takoe-obyasnenie-termina-prostymi-slovami.html