Entropie: qu’est-ce que c’est en termes simples. Entropie qu’est-ce que c’est: explication du terme en mots simples

Définition

L’entropie (traduit du grec ancien – tour, transformation) est une mesure, le degré de désordre (chaos) de tout système. Utilisé dans les sciences exactes et naturelles suivantes:

- En mathématiques, cela signifie trouver le logarithme du nombre d’états système disponibles;

- En science statistique, la valeur probabiliste de l’apparition de tout état macroscopique du système;

- En thermodynamique (physique), le degré de diffusion irréversible de l’énergie, c’est-à-dire la valeur standard de ses pertes, qui sont inévitables lorsqu’un corps plus chaud interagit avec un corps plus froid;

- En informatique, cela signifie la capacité d’information du système. Un fait intéressant est le suivant: Claude Shannon (le fondateur de ce terme en théorie de l’information) pensait à l’origine appeler information d’entropie.

À peu près compliqué

L’entropie est un concept utilisé dans plus d’un domaine de l’activité humaine, de sorte que ses définitions peuvent être quelque peu vagues. Ce terme reflète une valeur, et son essence peut être démontée avec des exemples simples. L’entropie est le degré de désordre, le degré d’incertitude et de désordre.

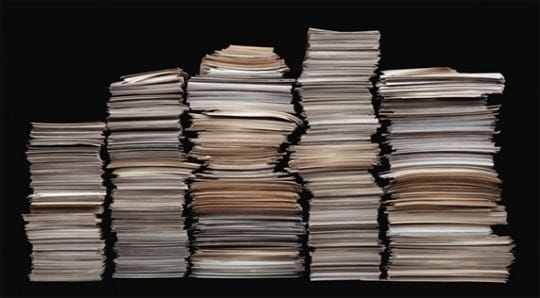

Une entropie élevée peut être visualisée comme une rue avec des bouts de papier épars. Si les papiers sont soigneusement empilés dans une pile, le système est ordonné et l’entropie est faible. Les valeurs d’entropie doivent être abaissées et pour cela, vous devez passer beaucoup de temps, coller les papiers pièce par pièce et les mettre en pile.

Si l’entropie d’un système fermé a lieu, alors tout est également simple ici. Un système fermé peut être imaginé comme une armoire fermée, si des choses y sont dispersées, il ne sera pas possible de les influencer de l’extérieur et le chaos dans l’armoire sera présent pendant longtemps.

Au fil du temps, les choses se décomposeront, et cela mènera à l’ordre, mais les choses doivent se décomposer pendant longtemps, par exemple, cela prendra 5 ans pour une chaussette en laine et environ 40 ans pour des chaussures en cuir. Dans cet exemple, le placard agit comme un système isolé, et la décomposition des choses en lui met de l’ordre dans les structures.

Le minimum est l’entropie, qui concerne les objets macroscopiques, ils peuvent être observés à l’œil nu. Quant aux indicateurs supérieurs, ils ont souvent un vide.

Histoire d’origine

Pour la première fois, le concept d’entropie a été introduit à l’ère du développement de la thermodynamique, lorsque le besoin s’est fait sentir d’étudier les processus se produisant à l’intérieur des corps thermodynamiques. En 1865, un physicien allemand, Rudolf Clausius, décrivait avec ce terme l’état d’un système dans lequel la chaleur a la capacité de se transformer en d’autres types d’énergie (mécanique, chimique, lumineuse, etc.).

L’augmentation de l’entropie est causée par l’afflux d’énergie thermique dans le système et est associée à la température à laquelle cet afflux se produit. La nécessité de cette valeur était due au fait que toute physique est basée sur l’idéalisation d’objets abstraits (pendule idéal, mouvement uniforme, masse, etc.).

Au sens quotidien, l’ entropie est le degré de chaos et d’incertitude du système: plus il y a d’ordre dans le système, et plus ses éléments sont subordonnés à un ordre, moins il y a d’entropie.

Exemple: une armoire est un système spécifique. Si tout y est à sa place, alors l’entropie est moindre. Si toutes les choses sont dispersées et non sur leurs étagères, cela devient alors plus grand.

La fonction thermique de l’enthalpie est étroitement liée à ce terme – elle caractérise l’état d’un système thermodynamique dans un état d’équilibre lors du choix d’un certain nombre de variables indépendantes, telles que la pression, l’entropie et le nombre de particules.

Le contraire de l’entropie est appelé extropie.

Types d’entropie

Le terme est utilisé en thermodynamique, en économie, en théorie de l’information et même en sociologie. Que définit-il dans ces domaines?

En chimie physique (thermodynamique)

Le postulat principal de la thermodynamique sur l’équilibre: tout système thermodynamique isolé arrive à un état d’équilibre dans le temps et ne peut en sortir spontanément. Autrement dit, chaque système tend vers un état d’équilibre pour lui. Et pour parler en termes très simples, un tel état est caractérisé par le désordre.

Le postulat principal de la thermodynamique sur l’équilibre: tout système thermodynamique isolé arrive à un état d’équilibre dans le temps et ne peut en sortir spontanément. Autrement dit, chaque système tend vers un état d’équilibre pour lui. Et pour parler en termes très simples, un tel état est caractérisé par le désordre.

L’entropie est une mesure du désordre. Comment identifier un désordre? Une façon consiste à attribuer à chaque état le nombre d’options pouvant être utilisées pour implémenter cet état. Et plus de tels modes de mise en œuvre sont nombreux, plus la valeur de l’entropie est grande. Plus une substance est organisée (sa structure), plus son incertitude (caractère aléatoire) est faible.

La valeur absolue de l’entropie (S abs.) Est égale à la variation de l’énergie disponible pour une substance ou un système lors d’un transfert de chaleur à une température donnée. Sa valeur mathématique est déterminée à partir de la valeur du transfert de chaleur (Q) divisée par la température absolue (T) à laquelle le processus se déroule: S abs. Q / T. Cela signifie que lors du transfert d’une grande quantité de chaleur, le S abs. augmentera. Le même effet sera observé pour le transfert de chaleur à basses températures.

En économie

L’économie utilise un concept tel que le coefficient d’entropie. À l’aide de ce coefficient, l’évolution de la concentration du marché et son niveau sont étudiés. Plus la valeur du coefficient est élevée, plus l’incertitude économique est élevée et, par conséquent, la probabilité d’émergence d’un monopole diminue. Le coefficient permet d’évaluer indirectement les avantages acquis par l’entreprise du fait d’éventuelles activités de monopole ou de changements dans la concentration du marché.

En physique statistique ou théorie de l’information

L’entropie de l’information (incertitude) est une mesure de l’imprévisibilité ou de l’incertitude d’un certain système. Cette valeur aide à déterminer le degré de désordre dans l’expérience ou l’événement en cours. Plus le nombre d’états dans lesquels le système peut se trouver est élevé, plus la valeur de l’incertitude est élevée. Tous les processus de commande du système conduisent à l’émergence de l’information et à la réduction de l’incertitude de l’information.

À l’aide de l’imprévisibilité des informations, il est possible d’identifier une telle capacité de canal qui garantira une transmission fiable des informations (dans un système de symboles codés). Et vous pouvez également prédire partiellement le cours de l’expérience ou des événements, en les divisant en leurs composants et en calculant la valeur de l’incertitude pour chacun d’eux. Cette méthode de physique statistique permet de révéler la probabilité d’un événement. Avec son aide, vous pouvez déchiffrer le texte encodé en analysant la probabilité d’apparition des symboles et leur indice d’entropie.

Il y a une chose telle que l’entropie absolue d’une langue. Cette valeur exprime la quantité maximale d’informations qui peuvent être véhiculées dans une unité de cette langue. Dans ce cas, le symbole de l’alphabet de la langue (bit) est pris comme unité.

En sociologie

Ici, l’entropie (incertitude de l’information) est une caractéristique de la déviation de la société (du système) ou de ses liens par rapport à l’état (de référence) accepté, et cela se manifeste par une diminution de l’efficacité du développement et du fonctionnement du système, une détérioration de soi -organisation. Un exemple simple: les salariés d’une entreprise sont tellement chargés de travail (effectuant un grand nombre de rapports) qu’ils n’ont pas le temps de s’engager dans leur activité principale (effectuer des contrôles). Dans cet exemple, la mesure de l’utilisation inappropriée des ressources de travail par la direction sera l’incertitude de l’information.

Comment l’entropie se manifeste dans nos vies

Avec l’aide de l’entropie, vous pouvez expliquer de nombreux faits incompréhensibles et surprenants, par exemple:

Pourquoi notre vie est-elle si extraordinaire

Imaginez le corps humain. Les atomes qui composent le corps auraient pu se plier en un nombre presque infini de variantes et ne créer aucune forme de vie. Du point de vue des mathématiques, la probabilité de notre existence est très faible. Et pourtant nous existons.

Dans un univers où l’entropie régit tout, l’existence de la vie avec une organisation aussi claire et stable est étonnante.

Pourquoi nous aimons l’art et la beauté

L’entropie peut expliquer pourquoi l’art et la beauté nous semblent si esthétiques. L’artiste crée une forme spéciale d’ordre et de symétrie que l’Univers n’aurait probablement jamais généré de lui-même. Le nombre de belles combinaisons est bien inférieur au nombre total de toutes les combinaisons. La beauté est une rareté dans un univers plein de désordre. Par conséquent, un visage symétrique est rare et beau, car il existe incomparablement plus d’options asymétriques.

Pourquoi avez-vous besoin de créer les conditions idéales pour vous-même?

Chacun de nous a ses propres talents, compétences et intérêts. Mais la société et la culture dans lesquelles nous vivons n’ont pas été créées spécialement pour nous. Avec l’entropie à l’esprit, considérez quelles sont les chances que l’environnement dans lequel vous avez grandi soit idéal pour libérer vos talents?

Il est extrêmement improbable que la vie crée pour vous une situation qui convienne parfaitement à vos capacités. Très probablement, vous vous retrouverez dans une position qui ne correspond pas tout à fait à vos compétences et à vos besoins.

Nous décrivons généralement un tel état comme «hors de propos», «hors de leur élément». Naturellement, dans de telles conditions, il est beaucoup plus difficile de réussir, d’être utile, de gagner. Sachant cela, nous devons nous créer des conditions de vie idéales pour nous-mêmes.Les difficultés de la vie ne surviennent pas parce que les planètes sont si alignées, et pas parce que certaines puissances supérieures ont conspiré contre vous. C’est juste la loi de l’entropie au travail. Il y a beaucoup plus d’états de désordre que d’états ordonnés. Avec tout cela à l’esprit, il n’est pas surprenant qu’il y ait des problèmes dans la vie, mais que nous puissions les résoudre.

Équation et calcul de l’entropie

Il existe plusieurs façons de calculer l’entropie. Mais les deux équations les plus courantes concernent les processus thermodynamiques et isothermes réversibles (à température constante).

Entropie et mort par la chaleur de l’univers

Certains scientifiques prédisent que l’entropie de l’univers augmentera à un point tel qu’elle créera un système incapable de faire un travail utile. Et seule l’énergie thermique restera. L’univers, disent-ils, mourra de mort par la chaleur.

Cependant, d’autres scientifiques contestent la théorie de la mort par la chaleur. Ils soutiennent que l’univers en tant que système s’éloigne de plus en plus de l’entropie. Même si l’entropie à l’intérieur de certaines de ses régions internes

augmente.

D’autres voient l’univers comme faisant partie d’un système encore plus vaste. D’autres encore disent que les états possibles n’ont pas la même probabilité. Par conséquent, les équations habituelles pour calculer l’entropie ne sont pas pertinentes.

Les formulations d’entropie les plus courantes en physique

De nombreux physiciens célèbres ont tenté d’expliquer le concept d’entropie d’une manière accessible aux gens ordinaires. Soulignons les 3 formulations les plus connues de l’explication.

Déclaration de Clausius

Chauffer un corps avec une température plus élevée n’est pas possible avec un corps avec une température plus basse.

Par exemple, cela ressemble à ceci – vous pouvez mettre une bouilloire avec de l’eau sur un morceau de glace (a priori, la température de l’eau est plus élevée que la température de la glace), mais vous ne pouvez pas attendre que l’eau bout. Bien que les 2 premiers débuts de la thermodynamique ne nient pas cette possibilité.

La formulation de Thomson

Dans un système fermé, un processus est impossible, dont le seul résultat serait un travail effectué en raison de l’énergie thermique reçue de n’importe quel corps.

Déclaration de Boltzmann

Une diminution de l’entropie dans un système fermé est impossible.

Cette formulation suscite beaucoup de controverses, même si tout est intuitivement clair. Le chaos grandira dans une habitation abandonnée – la poussière se déposera, certaines choses s’effondreront. Vous pouvez mettre les choses en ordre, mais uniquement en appliquant une énergie externe, c’est-à-dire le travail d’un nettoyeur.

Le problème est que l’Univers dans les concepts modernes est un système fermé. Il a été formé il y a 14 à 15 milliards d’années. Pendant ce temps, son entropie conduirait au fait que les galaxies se désintégraient, les étoiles s’éteindraient et aucune nouvelle étoile n’apparaîtrait en principe. Mais notre Soleil n’a pas plus de 5 milliards d’années, et l’Univers dans son ensemble n’est pas entré dans un état de chaos.

Entropie: thèse et exemples

Un exemple. Programme T9. Si un mot contient un petit nombre de fautes de frappe, le programme reconnaîtra facilement le mot et suggérera son remplacement. Plus il y a de fautes de frappe, moins le programme aura d’informations sur le mot saisi. Par conséquent, une augmentation de la confusion entraînera une augmentation de l’incertitude de l’information, et vice versa, plus il y a d’informations, moins l’incertitude est faible.

Exemple. Dé. Il n’y a qu’une seule façon de jeter une combinaison de 12 ou 2: 1 plus 1 ou 6 plus 6. Et le nombre maximum de façons est de 7 (a 6 combinaisons possibles). L’imprévisibilité de la mise en œuvre du chiffre sept est la plus grande dans ce cas.

- Dans un sens général, l’entropie (S) peut être comprise comme une mesure de la distribution d’énergie. À une faible valeur de S, l’énergie est concentrée et à une valeur élevée, elle est distribuée de manière chaotique.

Exemple. H2O (connu de toutes les eaux) dans son état liquide d’agrégation aura une plus grande entropie que dans le solide (glace). Parce que dans un solide cristallin, chaque atome occupe une certaine position dans le réseau cristallin (ordre), et à l’état liquide, les atomes n’ont pas certaines positions fixes (désordre). Autrement dit, un corps avec une disposition d’atomes plus rigide a une valeur d’entropie plus faible (S). Le diamant blanc sans impuretés a la valeur S la plus basse par rapport aux autres cristaux.

Exemple. La molécule est dans un vaisseau qui a un côté gauche et un côté droit. Si l’on ne sait pas dans quelle partie du vaisseau se trouve la molécule, alors l’entropie (S) sera déterminée par la formule S = S max = k lgW, où k est le nombre de méthodes de mise en œuvre, W est le nombre de parties du navire. Les informations dans ce cas seront égales à zéro I = I min = 0. Si l’on sait exactement dans quelle partie du vaisseau se trouve la molécule, alors S = S min = k ln1 = 0, et I = I max = log 2 W.Par conséquent, plus il y a d’informations, plus la valeur de l’incertitude de l’information est faible .

Exemple. Plus l’ordre sur le bureau est élevé, plus vous pouvez en savoir plus sur les éléments qui s’y trouvent. Dans ce cas, l’ordre des objets réduit l’entropie du système «bureau».

Exemple. Il y a plus d’informations sur la classe pendant la leçon que pendant la pause. L’entropie de la leçon est ci-dessous, car les élèves sont assis de manière ordonnée (plus d’informations sur l’emplacement de chaque élève). Et pendant les pauses, la disposition des élèves change de manière chaotique, ce qui augmente leur entropie.

Exemple. Lorsqu’un métal alcalin réagit avec l’eau, de l’hydrogène est libéré. L’hydrogène est un gaz. Étant donné que les molécules de gaz se déplacent de manière chaotique et ont une entropie élevée, la réaction considérée se produit avec une augmentation de sa valeur.

De la vie quotidienne:

- Lors de la rédaction de SMS sur un téléphone mobile, nous utilisons souvent le programme T9. Moins il y a d’erreurs dans le mot que nous tapons, plus il sera facile de le reconnaître par le programme et plus vite il nous proposera son remplacement. Conclusion: plus il y a de confusion, plus l’incertitude de l’information est grande.

- Lorsque nous lançons deux dés en jouant aux dés, il n’y a qu’une seule façon de lancer une combinaison de 2 ou 12 (1 et 1, 6 et 6). Le nombre maximum de façons de déployer le chiffre 7 (6 combinaisons possibles). L’imprévisibilité dans ce cas sera maximale.

- Il y a plus d’informations sur le nombre d’élèves pendant la leçon que pendant la pause. Puisque dans la leçon, chaque élève est assis à sa place, l’entropie est plus faible. En dehors de la salle de classe, le mouvement des écoliers est caractérisé par le chaos, ce qui conduit à une augmentation de la valeur de l’entropie.

- Si vous nettoyez le bureau, mettez des objets à leur place, vous pouvez obtenir plus d’informations sur tel ou tel objet. L’ordre des choses sur le bureau réduit la quantité d’entropie.

Important! Tout ce qui nous entoure tend à augmenter l’entropie. Une personne a l’intention de recevoir le maximum d’informations du monde qui l’entoure. Toutes les directions théoriques de l’étude de l’entropie (en physique, chimie, économie, mathématiques, sociologie) visent à établir un équilibre (équilibre) entre les intentions et les désirs des personnes et les processus naturels qui se produisent dans la nature.

Entropie: qu’est-ce que c’est en mots simples

La langue russe, comme toute autre, est en constante évolution sous la pression de l’emprunt technologique constant et de la coopération avec d’autres États. Grâce à cela, notre langue est riche de divers emprunts en langues étrangères.

L’un des mots relativement nouveaux de la langue russe était le mot «entropie», qui a été rencontré par beaucoup d’entre nous, mais tout le monde ne comprend pas ce qu’il signifie vraiment.

Qu’est-ce que l’entropie en mots simples

Le plus souvent, le mot «entropie» se retrouve, bien entendu, en physique classique. C’est l’un des concepts les plus difficiles de cette science, par conséquent, même les étudiants des universités de physique rencontrent souvent des problèmes dans la perception de ce terme.

Il s’agit d’une coordonnée très spécifique – la capitale de la Fédération de Russie – cependant, Moscou est une ville plutôt grande, vous ne connaissez donc toujours pas les informations exactes sur ma situation géographique. Mais quand je vous dis mon code postal, par exemple, l’entropie à mon sujet, en tant qu’objet, diminuera.

Ce n’est pas une analogie entièrement exacte, alors donnons un autre exemple à clarifier. Disons que nous prenons dix dés à six faces. Jetons-les tous à tour de rôle, puis je vous dirai le total des indicateurs abandonnés – trente.

Sur la base de la somme de tous les résultats, vous ne pourrez pas dire avec certitude quel chiffre et sur quel dé est tombé – vous n’avez tout simplement pas assez de données pour cela. Dans notre cas, chaque chiffre abandonné dans la langue des physiciens sera appelé un micro-état, et un montant égal à trente, dans le même dialecte physique, sera appelé un macro-état.

Si nous calculons combien de micro-états possibles trois douzaines peuvent nous donner au total, nous arrivons à la conclusion que leur nombre atteint près de trois millions de valeurs. En utilisant une formule spéciale, nous pouvons calculer l’indice d’entropie dans cette expérience probabiliste – six et demi.

D’où vient la moitié, pourriez-vous demander? Cette partie fractionnaire apparaît du fait que lors de la numérotation dans le septième ordre, nous pouvons fonctionner avec seulement trois nombres – 0, 1 et 2.

Le mot moderne «entropie» a des racines grecques, par conséquent, en raison de la traduction, il est souvent appelé la «mesure du chaos». Disons que vous décidez de vous régaler dans votre appartement à l’occasion de l’anniversaire de votre petite fille.

Ils ont nettoyé tout l’appartement, lavé les sols et les fenêtres, lavé la vaisselle, puis disposé toute la vaisselle magnifiquement et élégamment sur la table. Le chaos domestique initial de votre appartement a considérablement diminué, par conséquent, votre maison est devenue un système à faible entropie.

Entropie dans l’univers

Selon les prévisions des astrophysiciens, l’une des options pour le développement de l’Univers est la mort par la chaleur.

Notre univers est (imaginez à quel point les anciens Grecs étaient clairvoyants à cet égard) un pur chaos, dans lequel quelque chose se passe constamment: des étoiles naissent et meurent, de nouvelles galaxies se forment, bref, de la beauté! À un moment donné, l’entropie de l’Univers atteindra son maximum et il n’y aura tout simplement rien à y faire. Voilà pour la mort par oisiveté.

Le chaos imprègne tout le cosmos, toute notre nature, jusqu’aux atomes et aux particules élémentaires. Tout est en mouvement et en interaction constants, comme un mécanisme parfaitement travaillé. Et tous ces processus sont régis par des lois que nous, personnes misérables, pouvons exprimer dans un langage mathématique non moins beau.

Mais comment, avec un tel niveau d’entropie (c’est-à-dire le chaos) dans l’Univers, quoi que ce soit aurait-il pu survenir? La réponse à cette question est extrêmement simple. Toute matière transfère le niveau de son entropie à son propre environnement, tout ce qu’elle peut atteindre.

Par exemple, pour réguler le niveau d’entropie sur Terre, une étoile nommée Soleil nous fournit constamment de l’énergie, qu’elle produit en raison d’une réaction thermonucléaire incessante à sa surface.

Si notre planète était un système fermé, alors, selon la deuxième loi de la thermodynamique, l’entropie à l’intérieur ne pourrait qu’augmenter, mais, comme vous l’avez déjà compris, le Soleil nous permet de maintenir le niveau d’entropie de la Terre normal.

L’entropie et le chaos imprègnent tout ce qui nous entoure et même ce qui est en nous. Dans les gaz et les liquides, l’entropie joue un rôle clé, même nos désirs et impulsions momentanés ne sont en fait rien de plus qu’un produit du chaos universel universel.

Il n’est pas difficile de revenir à la plus belle conclusion: l’Univers, aussi énorme soit-il, est une collection d’un nombre infini de particules de la taille la plus diverse et des propriétés non moins diverses.

Tout ce qu’il contient, du boson élémentaire à Alpha du Centaure et aux galaxies entières, est relié par des fils invisibles. De telles découvertes de physiciens sont frappantes non seulement par leur complexité, mais aussi par leur beauté.

Il semblerait que les formules mathématiques et physiques habituelles sur les planches d’hommes pensifs non rasés avec des lunettes soient des facteurs clés pour notre connaissance de nous-mêmes et de nous-mêmes et de notre place dans le vaste Univers.

Nous espérons que cet article vous a aidé à clarifier ce qu’est réellement l’entropie, dans quels cas ce mot est utilisé, et aussi ce à quoi la découverte de cet indicateur a conduit les scientifiques et les philosophes.

Qui sait, peut-être que la lecture de cet article vous inspirera à étudier délibérément cette merveilleuse science – la physique. D’une manière ou d’une autre, il est d’une importance vitale pour une personne moderne de s’intéresser à la science, au moins pour son propre développement.

Pour terminer

Si nous combinons tout ce qui précède, il s’avère que l’entropie est une mesure du désordre ou de l’incertitude du système et de ses parties. Un fait intéressant est que tout dans la nature tend vers l’entropie maximale, et l’homme – vers le maximum d’informations.

Sources utilisées et liens utiles sur le sujet: https://advi.club/psihologiya-i-obshhestvo/183-entropiya-prostymi-slovami.html https://obraz-ola.ru/prochee/razbiraemsya-chto-takoe- entropiya .html https://tvercult.ru/nauka/entropiya-chto-eto-takoe-obyasnenie-termina-prostyimi-slovami https://Lifehacker.ru/entropy/ https://zen.yandex.ru/media/ alivespace / chto-takoe-entropiia-5d98e1ab43863f00b19f8f80 https://zen.yandex.ru/media/popsci/chto-takoe-entropiia-i-kak-ona-sviazana-s-materiei-i-energiei-5c55ad1uru280ezed00aegrabovae . / nauka / entropiya-chto-eto-takoe-obyasnenie-termina-prostymi-slovami.html