Entropie: Was ist das in einfachen Worten? Entropie was ist das: Erklärung des Begriffs in einfachen Worten

Definition

Die Entropie (übersetzt aus dem Altgriechischen – Wende, Transformation) ist ein Maß für den Grad der Unordnung (Chaos) eines jeden Systems. Wird in den folgenden exakten und naturwissenschaftlichen Bereichen verwendet:

- In der Mathematik bedeutet dies, den Logarithmus der Anzahl der verfügbaren Systemzustände zu ermitteln.

- In der statistischen Wissenschaft der Wahrscheinlichkeitswert des Einsetzens eines makroskopischen Zustands des Systems;

- In der Thermodynamik (Physik) ist der Grad der irreversiblen Diffusion von Energie, d.h. der Standardwert seiner Verluste, die unvermeidlich sind, wenn ein heißer Körper mit einem kälteren interagiert;

- In der Informatik bedeutet dies die Informationskapazität des Systems. Eine interessante Tatsache ist die folgende: Claude Shannon (der Begründer dieses Begriffs in der Informationstheorie) dachte ursprünglich, Entropie-Informationen zu nennen.

Fast kompliziert

Entropie ist ein Konzept, das in mehr als einem Bereich menschlicher Aktivität verwendet wird, daher können seine Definitionen etwas vage sein. Dieser Begriff spiegelt einen Wert wider und sein Wesen kann anhand einfacher Beispiele zerlegt werden. Entropie ist der Grad der Störung, der Grad der Unsicherheit und Störung.

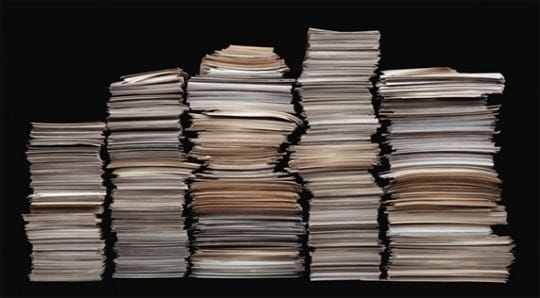

Hohe Entropie kann als Straße mit verstreuten Papierfetzen dargestellt werden. Wenn die Papiere ordentlich auf einem Stapel gestapelt sind, wird das System bestellt und die Entropie ist gering. Die Entropiewerte müssen gesenkt werden, und dafür müssen Sie viel Zeit aufwenden, die Papiere Stück für Stück kleben und auf einen Stapel legen.

Wenn die Entropie eines geschlossenen Systems stattfindet, ist auch hier alles einfach. Ein geschlossenes System kann man sich als geschlossenen Schrank vorstellen. Wenn Dinge darin verstreut sind, ist es unmöglich, sie von außen zu beeinflussen, und das Chaos im Schrank wird für lange Zeit vorhanden sein.

Mit der Zeit werden sich die Dinge zersetzen, und dies wird zu Ordnung führen, aber die Dinge müssen sich für eine lange Zeit zersetzen, zum Beispiel wird es 5 Jahre für eine Wollsocke und ungefähr 40 Jahre für Lederschuhe dauern. In dem gegebenen Beispiel fungiert der Schrank als isoliertes System, und die Zerlegung der darin enthaltenen Dinge bringt die Dinge in Ordnung in die Strukturen.

Das Minimum ist die Entropie, die makroskopische Objekte betrifft, sie können mit bloßem Auge beobachtet werden. Die höheren Indikatoren haben oft ein Vakuum.

Herkunftsgeschichte

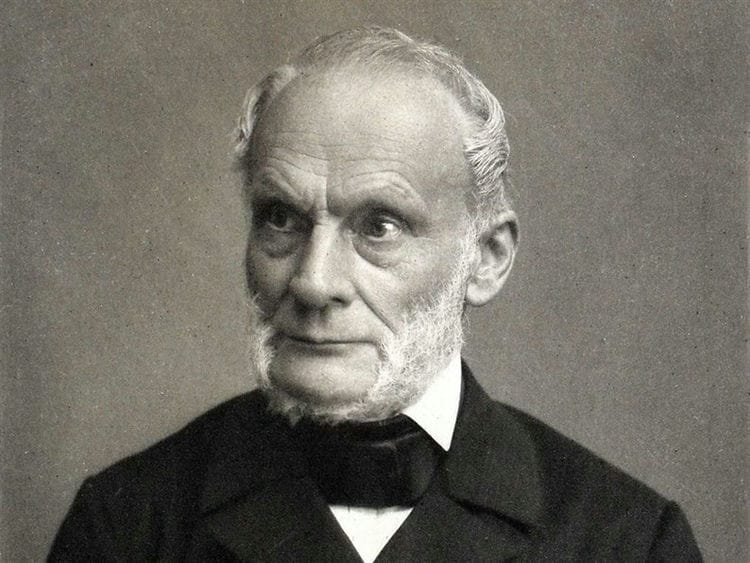

Das Konzept der Entropie wurde erstmals im Zeitalter der Entwicklung der Thermodynamik eingeführt, als die Notwendigkeit bestand, die in thermodynamischen Körpern ablaufenden Prozesse zu untersuchen. 1865 beschrieb ein Physiker aus Deutschland, Rudolf Clausius, mit diesem Begriff den Zustand eines Systems, in dem Wärme in andere Energiearten (mechanisch, chemisch, leicht usw.) umgewandelt werden kann.

Die Zunahme der Entropie wird durch den Einstrom von Wärmeenergie in das System verursacht und hängt mit der Temperatur zusammen, bei der dieser Einstrom auftritt. Die Notwendigkeit für diesen Wert beruhte auf der Tatsache, dass die gesamte Physik auf der Idealisierung abstrakter Objekte (ideales Pendel, gleichmäßige Bewegung, Masse usw.) basiert.

Entropie ist im alltäglichen Sinne der Grad des Chaos und der Unsicherheit des Systems: Je mehr Ordnung im System und je mehr seine Elemente einer Ordnung untergeordnet sind, desto weniger Entropie.

Beispiel: Ein Schrank ist ein bestimmtes System. Wenn darin alle Dinge an ihrem Platz sind, dann ist die Entropie geringer. Wenn alle Dinge verstreut sind und nicht in ihren Regalen stehen, wird es dementsprechend größer.

Die thermische Funktion der Enthalpie ist eng mit diesem Begriff verbunden – sie charakterisiert den Zustand eines thermodynamischen Systems in einem Gleichgewichtszustand, wenn eine Reihe unabhängiger Variablen wie Druck, Entropie und Anzahl der Partikel ausgewählt werden.

Das Gegenteil von Entropie heißt Extropie.

Arten von Entropien

Der Begriff wird in der Thermodynamik, Ökonomie, Informationstheorie und sogar Soziologie verwendet. Was definiert er in diesen Bereichen?

In der physikalischen Chemie (Thermodynamik)

Das Grundpostulat der Thermodynamik über das Gleichgewicht: Jedes isolierte thermodynamische System kommt im Laufe der Zeit in einen Gleichgewichtszustand und kann nicht spontan aus diesem herauskommen. Das heißt, jedes System tendiert dazu, einen Gleichgewichtszustand zu erreichen. Und in sehr einfachen Worten ausgedrückt, ist ein solcher Zustand durch Unordnung gekennzeichnet.

Das Grundpostulat der Thermodynamik über das Gleichgewicht: Jedes isolierte thermodynamische System kommt im Laufe der Zeit in einen Gleichgewichtszustand und kann nicht spontan aus diesem herauskommen. Das heißt, jedes System tendiert dazu, einen Gleichgewichtszustand zu erreichen. Und in sehr einfachen Worten ausgedrückt, ist ein solcher Zustand durch Unordnung gekennzeichnet.

Die Entropie ist ein Maß für die Störung. Wie erkennt man ein Durcheinander? Eine Möglichkeit besteht darin, jedem Status die Anzahl der Optionen zuzuweisen, mit denen dieser Status implementiert werden kann. Und je mehr solche Implementierungsmethoden vorhanden sind, desto größer ist der Wert der Entropie. Je organisierter eine Substanz (ihre Struktur) ist, desto geringer ist ihre Unsicherheit (Zufälligkeit).

Der absolute Entropiewert (S abs.) Ist gleich der Änderung der Energie, die einem Stoff oder System während der Wärmeübertragung bei einer bestimmten Temperatur zur Verfügung steht. Sein mathematischer Wert wird aus dem Wert der Wärmeübertragung (Q) geteilt durch die absolute Temperatur (T) bestimmt, bei der der Prozess stattfindet: S abs. Q / T. Dies bedeutet, dass bei der Übertragung einer großen Wärmemenge die S abs. wird steigen. Der gleiche Effekt wird bei der Wärmeübertragung bei niedrigen Temperaturen beobachtet.

In Wirtschaft

Die Wirtschaft verwendet ein solches Konzept als Entropiekoeffizienten. Mit Hilfe dieses Koeffizienten werden die Veränderung der Marktkonzentration und deren Höhe untersucht. Je höher der Wert des Koeffizienten ist, desto höher ist die wirtschaftliche Unsicherheit und damit die Wahrscheinlichkeit, dass ein Monopol entsteht. Der Koeffizient hilft bei der indirekten Bewertung der Vorteile, die das Unternehmen aufgrund möglicher Monopolaktivitäten oder Änderungen der Marktkonzentration erzielt.

In der statistischen Physik oder Informationstheorie

Die Informationsentropie (Unsicherheit) ist ein Maß für die Unvorhersehbarkeit oder Unsicherheit eines bestimmten Systems. Dieser Wert hilft, den Grad der Zufälligkeit des durchgeführten Experiments oder Ereignisses zu bestimmen. Je mehr Zustände das System haben kann, desto größer ist der Wert der Unsicherheit. Alle Prozesse der Bestellung des Systems führen zur Entstehung von Informationen und zur Verringerung der Informationsunsicherheit.

Mit Hilfe der Unvorhersehbarkeit von Informationen ist es möglich, eine solche Kanalkapazität zu identifizieren, die eine zuverlässige Übertragung von Informationen gewährleistet (in einem System von codierten Symbolen). Sie können auch den Verlauf von Erfahrungen oder Ereignissen teilweise vorhersagen, sie in ihre Bestandteile unterteilen und den Wert der Unsicherheit für jeden von ihnen berechnen. Diese Methode der statistischen Physik hilft, die Wahrscheinlichkeit eines Ereignisses aufzudecken. Mit seiner Hilfe können Sie den codierten Text entschlüsseln und die Wahrscheinlichkeit des Auftretens von Symbolen und deren Entropieindex analysieren.

Es gibt so etwas wie die absolute Entropie einer Sprache. Dieser Wert drückt die maximale Menge an Informationen aus, die in einer Einheit dieser Sprache übermittelt werden können. In diesem Fall wird das Symbol des Alphabets der Sprache (Bit) als Einheit genommen.

In der Soziologie

Hier ist Entropie (Informationsunsicherheit) ein Merkmal der Abweichung der Gesellschaft (des Systems) oder ihrer Verbindungen vom akzeptierten (Referenz-) Zustand, und dies äußert sich in einer Abnahme der Effizienz der Entwicklung und Funktionsweise des Systems, einer Verschlechterung des Selbst -Organisation. Ein einfaches Beispiel: Mitarbeiter eines Unternehmens sind so stark mit Arbeit belastet (sie führen eine große Anzahl von Berichten durch), dass sie keine Zeit haben, sich ihrer Haupttätigkeit zu widmen (Überprüfungen durchzuführen). In diesem Beispiel ist die Informationsunsicherheit ein Maß für den unangemessenen Einsatz von Arbeitsressourcen durch das Management.

Wie sich Entropie in unserem Leben manifestiert

Mit Hilfe der Entropie können Sie viele unverständliche und überraschende Fakten erklären, zum Beispiel:

Warum ist unser Leben so außergewöhnlich?

Stellen Sie sich den menschlichen Körper vor. Die Atome, aus denen der Körper besteht, könnten sich in eine nahezu unendliche Anzahl von Varianten gefaltet haben und keine Form von Leben schaffen. Aus mathematischer Sicht ist die Wahrscheinlichkeit unserer Existenz sehr gering. Und doch existieren wir.

In einem Universum, in dem Entropie alles regiert, ist die Existenz eines Lebens mit einer so klaren und stabilen Organisation erstaunlich.

Warum wir Kunst und Schönheit lieben

Entropie kann erklären, warum Kunst und Schönheit uns so ästhetisch erscheinen. Der Künstler schafft eine besondere Form der Ordnung und Symmetrie, die das Universum höchstwahrscheinlich niemals alleine erzeugt hätte. Die Anzahl der schönen Kombinationen ist viel geringer als die Gesamtzahl aller Kombinationen. Schönheit ist eine Seltenheit in einem Universum voller Unordnung. Daher ist ein symmetrisches Gesicht selten und schön, da es unvergleichlich asymmetrischere Optionen gibt.

Warum ideale Bedingungen für sich selbst nicht gefunden, sondern geschaffen werden sollten

Jeder von uns hat seine eigenen Talente, Fähigkeiten und Interessen. Aber die Gesellschaft und Kultur, in der wir leben, wurden nicht speziell für uns geschaffen. Überlegen Sie unter Berücksichtigung der Entropie, wie hoch die Chancen sind, dass das Umfeld, in dem Sie aufgewachsen sind, ideal ist, um Ihre Talente freizusetzen.

Es ist äußerst unwahrscheinlich, dass das Leben eine Situation für Sie schafft, die perfekt zu Ihren Fähigkeiten passt. Höchstwahrscheinlich befinden Sie sich in einer Position, die Ihren Fähigkeiten und Bedürfnissen nicht ganz entspricht.

Wir beschreiben diesen Zustand normalerweise als “fehl am Platz”, “außerhalb ihres Elements”. Natürlich ist es unter solchen Bedingungen viel schwieriger, Erfolg zu haben, nützlich zu sein, zu gewinnen. Wenn wir das wissen, müssen wir selbst ideale Lebensbedingungen für uns selbst schaffen. Schwierigkeiten im Leben entstehen nicht, weil die Planeten so aufgereiht sind und nicht, weil sich einige höhere Mächte gegen Sie verschworen haben. Es ist nur das Gesetz der Entropie bei der Arbeit. Es gibt viel mehr Unordnungszustände als geordnete. Vor diesem Hintergrund ist es nicht verwunderlich, dass es Probleme im Leben gibt, aber dass wir sie lösen können.

Gleichung und Berechnung der Entropie

Es gibt verschiedene Möglichkeiten, die Entropie zu berechnen. Die beiden häufigsten Gleichungen beziehen sich jedoch auf reversible thermodynamische und isotherme Prozesse (mit konstanter Temperatur).

Entropie und Hitzetod des Universums

Einige Wissenschaftler sagen voraus, dass die Entropie des Universums so stark zunehmen wird, dass ein System entsteht, das keine nützliche Arbeit leisten kann. Und es bleibt nur Wärmeenergie übrig. Das Universum, sagen sie, wird an Hitzetod sterben.

Andere Wissenschaftler bestreiten jedoch die Theorie des Hitzetodes. Sie argumentieren, dass sich das Universum als System immer weiter von der Entropie entfernt. Selbst wenn die Entropie in einigen seiner inneren Regionen

zunimmt.

Andere sehen das Universum als Teil eines noch größeren Systems. Wieder andere sagen, dass die möglichen Zustände nicht die gleiche Wahrscheinlichkeit haben. Daher sind die üblichen Gleichungen zur Berechnung der Entropie irrelevant.

Die gebräuchlichsten Formulierungen der Entropie in der Physik

Viele berühmte Physiker haben versucht, das Konzept der Entropie für gewöhnliche Menschen zugänglich zu erklären. Lassen Sie uns die 3 bekanntesten Formulierungen der Erklärung hervorheben.

Clausius ‘Aussage

Das Erhitzen eines Körpers mit einer höheren Temperatur ist mit einem Körper mit einer niedrigeren Temperatur nicht möglich.

Zum Beispiel sieht es so aus – Sie können einen Wasserkocher mit Wasser auf ein Stück Eis stellen (a priori ist die Wassertemperatur höher als die Eistemperatur), aber Sie können nicht warten, bis das Wasser kocht. Obwohl die ersten beiden Anfänge der Thermodynamik diese Möglichkeit nicht leugnen.

Thomsons Formulierung

In einem geschlossenen System ist ein Prozess unmöglich, dessen einziges Ergebnis die Arbeit ist, die aufgrund der von einem Körper empfangenen Wärmeenergie geleistet wird.

Boltzmanns Aussage

Eine Abnahme der Entropie in einem geschlossenen System ist nicht möglich.

Dieser Wortlaut sorgt für große Kontroversen, obwohl alles intuitiv klar ist. Das Chaos wird in einer verlassenen Wohnung wachsen – Staub wird sich absetzen, einige Dinge werden auseinanderfallen. Sie können die Dinge in Ordnung bringen, aber nur, indem Sie externe Energie anwenden, dh die Arbeit eines Reinigers.

Das Problem ist, dass das Universum in modernen Konzepten ein geschlossenes System ist. Es wurde vor 14-15 Milliarden Jahren gegründet. Während dieser Zeit würde seine Entropie dazu führen, dass die Galaxien zerfielen, die Sterne erloschen und im Prinzip keine neuen Sterne auftauchten. Aber unsere Sonne ist nicht älter als 5 Milliarden Jahre und das Universum als Ganzes ist nicht in einen Zustand des Chaos geraten.

Entropie: These und Beispiele

Ein Beispiel. T9-Programm. Wenn ein Wort eine kleine Anzahl von Tippfehlern enthält, erkennt das Programm das Wort leicht und schlägt seine Ersetzung vor. Je mehr Tippfehler, desto weniger Informationen hat das Programm über das eingegebene Wort. Folglich führt eine Zunahme der Verwirrung zu einer Zunahme der Informationsunsicherheit und umgekehrt, je mehr Informationen, desto weniger Unsicherheit.

Beispiel. Würfel. Es gibt nur einen Weg, eine Kombination aus 12 oder 2: 1 plus 1 oder 6 plus 6 wegzuwerfen. Die maximale Anzahl von Wegen beträgt 7 (hat 6 mögliche Kombinationen). Die Unvorhersehbarkeit der Implementierung der Nummer sieben ist in diesem Fall am größten.

- Im Allgemeinen kann Entropie (S) als Maß für die Energieverteilung verstanden werden. Bei einem niedrigen Wert von S ist die Energie konzentriert und bei einem hohen Wert ist sie chaotisch verteilt.

Beispiel. H2O (allen Wasser bekannt) hat in seinem flüssigen Aggregatzustand eine größere Entropie als in festem (Eis). Weil in einem kristallinen Feststoff jedes Atom eine bestimmte Position im Kristallgitter einnimmt (Ordnung) und in einem flüssigen Zustand haben Atome keine bestimmten festen Positionen (Störung). Das heißt, ein Körper mit einer starreren Anordnung von Atomen hat einen niedrigeren Entropiewert (S). Weißer Diamant ohne Verunreinigungen hat im Vergleich zu anderen Kristallen den niedrigsten S-Wert.

Beispiel. Das Molekül befindet sich in einem Gefäß mit einer linken und einer rechten Seite. Wenn nicht bekannt ist, in welchem Teil des Gefäßes sich das Molekül befindet, wird die Entropie (S) durch die Formel S = S max = k lgW bestimmt, wobei k die Anzahl der Implementierungsmethoden ist, W die Anzahl von Teile des Schiffes. Die Informationen sind in diesem Fall gleich Null. I = I min = 0. Wenn genau bekannt ist, in welchem Teil des Gefäßes sich das Molekül befindet, dann ist S = S min = k ln1 = 0 und I = I max = log 2 W. Je mehr Informationen vorhanden sind, desto geringer ist der Wert der Informationsunsicherheit .

Beispiel. Je höher die Reihenfolge auf dem Desktop, desto mehr Informationen können Sie über die darin enthaltenen Informationen erhalten. In diesem Fall verringert die Reihenfolge der Objekte die Entropie des “Desktop” -Systems.

Beispiel. Während des Unterrichts gibt es mehr Informationen über die Klasse als während der Pause. Die Entropie in der Lektion ist unten angegeben, da die Schüler ordentlich sitzen (weitere Informationen zum Standort jedes Schülers). Und in den Pausen ändert sich die Disposition der Schüler chaotisch, was ihre Entropie erhöht.

Beispiel. Wenn ein Alkalimetall mit Wasser reagiert, wird Wasserstoff freigesetzt. Wasserstoff ist ein Gas. Da sich Gasmoleküle chaotisch bewegen und eine hohe Entropie aufweisen, erfolgt die betrachtete Reaktion mit einer Wertsteigerung.

Aus dem Alltag:

- Beim Schreiben von SMS-Nachrichten auf einem Mobiltelefon verwenden wir häufig das Programm T9. Je weniger Fehler in dem von uns eingegebenen Wort enthalten sind, desto leichter erkennt das Programm es und desto schneller bietet es uns seinen Ersatz an. Fazit: Je mehr Verwirrung, desto größer die Informationsunsicherheit.

- Wenn wir beim Würfeln zwei Würfel werfen, gibt es nur einen Weg, eine Kombination aus 2 oder 12 zu würfeln (1 und 1, 6 und 6). Die maximale Anzahl von Möglichkeiten zum Ausrollen der Nummer 7 (6 mögliche Kombinationen). Die Unvorhersehbarkeit ist in diesem Fall maximal.

- Es gibt mehr Informationen über die Anzahl der Schüler während des Unterrichts als während der Pause. Da in der Lektion jeder Schüler an seiner Stelle sitzt, ist die Entropie geringer. Außerhalb des Klassenzimmers ist die Bewegung von Schulkindern durch Zufälligkeit gekennzeichnet, was zu einer Steigerung des Entropiewertes führt.

- Wenn Sie den Schreibtisch aufräumen und Gegenstände an ihren Platz stellen, können Sie weitere Informationen zu diesem oder jenem Gegenstand darauf erhalten. Die Ordnung der Dinge auf dem Schreibtisch reduziert die Entropie.

Wichtig! Alles, was uns umgibt, neigt dazu, die Entropie zu erhöhen. Eine Person beabsichtigt, die maximale Menge an Informationen von der Welt um sie herum zu erhalten. Alle theoretischen Richtungen beim Studium der Entropie (in Physik, Chemie, Wirtschaft, Mathematik, Soziologie) zielen darauf ab, ein Gleichgewicht zwischen den Absichten und Wünschen der Menschen und den natürlichen Prozessen in der Natur herzustellen.

Entropie: Was ist das in einfachen Worten?

Die russische Sprache ändert sich wie jede andere unter dem Druck ständiger technologischer Anleihen und der Zusammenarbeit mit anderen Staaten ständig. Dank dessen ist unsere Sprache reich an verschiedenen Fremdsprachenanleihen.

Eines der relativ neuen Wörter in der russischen Sprache war das Wort “Entropie”, das von vielen von uns angetroffen wurde, aber nicht jeder versteht, was es wirklich bedeutet.

Was ist Entropie in einfachen Worten

Am häufigsten kommt das Wort “Entropie” natürlich in der klassischen Physik vor. Dies ist eines der schwierigsten Konzepte dieser Wissenschaft, daher haben selbst Studenten von Physikuniversitäten häufig Probleme bei der Wahrnehmung dieses Begriffs.

Dies ist eine sehr spezifische Koordinate – die Hauptstadt der Russischen Föderation – Moskau ist jedoch eine ziemlich große Stadt, so dass Sie immer noch nicht die genauen Informationen über meinen Standort kennen. Aber wenn ich Ihnen zum Beispiel meine Postleitzahl sage, nimmt die Entropie über mich als Objekt ab.

Dies ist keine ganz genaue Analogie, daher werden wir zur Verdeutlichung ein weiteres Beispiel geben. Nehmen wir an, wir nehmen zehn sechsseitige Würfel. Lassen Sie uns sie alle der Reihe nach werfen, und dann werde ich Ihnen die Summe der abgelegten Indikatoren sagen – dreißig.

Anhand der Summe aller Ergebnisse können Sie nicht sicher sagen, welche Zahl und auf welchem Würfel herausgefallen ist – Sie haben einfach nicht genügend Daten dafür. In unserem Fall wird jede abgebrochene Ziffer in der Sprache der Physiker als Mikrozustand bezeichnet, und ein Betrag von dreißig im gleichen physischen Dialekt wird als Makrostate bezeichnet.

Wenn wir berechnen, wie viele mögliche Mikrozustände uns insgesamt drei Dutzend geben können, kommen wir zu dem Schluss, dass ihre Anzahl fast drei Millionen Werte erreicht. Mit einer speziellen Formel können wir den Entropieindex in diesem probabilistischen Experiment berechnen – sechseinhalb.

Woher kam die Hälfte, könnte man fragen? Dieser Bruchteil erscheint aufgrund der Tatsache, dass wir bei der Nummerierung in der siebten Ordnung nur mit drei Zahlen arbeiten können – 0, 1 und 2.

Das moderne Wort “Entropie” hat griechische Wurzeln, daher wird es aufgrund der Übersetzung oft als “Maß des Chaos” bezeichnet. Angenommen, Sie möchten anlässlich des Geburtstages Ihrer kleinen Tochter ein Festmahl in Ihrer Wohnung veranstalten.

Sie säuberten die gesamte Wohnung, wuschen die Böden und Fenster, spülten das Geschirr sauber und legten dann das gesamte Geschirr schön und elegant auf den Tisch. Das anfängliche Haushaltschaos Ihrer Wohnung hat sich erheblich verringert, daher ist Ihr Haus zu einem System mit geringer Entropie geworden.

Entropie im Universum

Nach den Prognosen von Astrophysikern ist eine der Optionen für die Entwicklung des Universums der Hitzetod.

Unser Universum ist (stellen Sie sich vor, wie weitsichtig die alten Griechen in dieser Hinsicht waren) ein Chaos, in dem ständig etwas passiert: Sterne werden geboren und sterben, neue Galaxien entstehen, kurz Schönheit! In einem schönen Moment wird die Entropie des Universums ihr Maximum erreichen und es wird einfach nichts darin passieren. Soviel zum Tod aus Müßiggang.

Chaos durchdringt den gesamten Kosmos, unsere gesamte Natur, bis hin zu Atomen und Elementarteilchen. Alles ist in ständiger Bewegung und Interaktion, wie ein wunderschön funktionierender Mechanismus. Und all diese Prozesse unterliegen Gesetzen, die wir, elende Menschen, in nicht weniger schöner mathematischer Sprache ausdrücken können.

Aber wie hätte bei einem solchen Grad an Entropie (dh Chaos) im Universum überhaupt etwas entstehen können? Die Antwort auf diese Frage ist äußerst einfach. Alle Materie überträgt das Niveau ihrer Entropie auf ihre eigene Umgebung, auf alles, was sie erreichen kann.

Um beispielsweise das Entropieniveau auf der Erde zu regulieren, liefert uns ein Stern namens Sonne ständig Energie, die er aufgrund einer unaufhörlichen thermonuklearen Reaktion auf seiner Oberfläche erzeugt.

Wenn unser Planet ein geschlossenes System wäre, könnte nach dem zweiten Hauptsatz der Thermodynamik die Entropie in ihm nur zunehmen, aber wie Sie bereits verstanden haben, erlaubt uns die Sonne, das Niveau der Entropie der Erde normal zu halten.

Entropie und Chaos durchdringen alles, was uns umgibt und sogar was in uns ist. In Gasen und Flüssigkeiten spielt die Entropie eine Schlüsselrolle, selbst unsere momentanen Wünsche und Impulse sind in der Tat nichts anderes als ein Produkt des universellen universellen Chaos.

Es ist nicht schwer, noch einmal zu dem schönsten Ergebnis zu kommen: Das Universum, egal wie groß es auch sein mag, ist eine Sammlung von unendlich vielen Teilchen unterschiedlichster Größe und nicht weniger unterschiedlicher Eigenschaften.

Alles darin, von einem elementaren Boson über Alpha Centauri bis hin zu ganzen Galaxien, ist durch unsichtbare Fäden verbunden. Solche Entdeckungen von Physikern fallen nicht nur in ihrer Komplexität auf, sondern auch in ihrer Schönheit.

Es scheint, dass die üblichen mathematischen und physikalischen Formeln auf den Brettern unrasierter nachdenklicher Männer mit Brille Schlüsselfaktoren für unser Wissen über uns selbst und unseren Platz im riesigen Universum sind.

Wir hoffen, dass dieser Artikel Ihnen geholfen hat zu klären, was Entropie wirklich ist, in welchen Fällen dieses Wort verwendet wird und wozu die Entdeckung dieses Indikators Wissenschaftler und Philosophen geführt hat.

Wer weiß, vielleicht inspiriert Sie das Lesen dieses Artikels dazu, diese wunderbare Wissenschaft – Physik – gezielt zu studieren. Auf die eine oder andere Weise ist es für einen modernen Menschen von entscheidender Bedeutung, sich für Wissenschaft zu interessieren, zumindest für seine eigene Entwicklung.

Abschließend

Wenn wir alle oben genannten Punkte kombinieren, stellt sich heraus, dass die Entropie ein Maß für die Störung oder Unsicherheit des Systems und seiner Teile ist. Eine interessante Tatsache ist, dass alles in der Natur zur maximalen Entropie und der Mensch zur maximalen Information tendiert.

Verwendete Quellen und nützliche Links zum Thema: https://advi.club/psihologiya-i-obshhestvo/183-entropiya-prostymi-slovami.html https://obraz-ola.ru/prochee/razbiraemsya-chto-takoe- entropiya .html https://tvercult.ru/nauka/entropiya-chto-eto-takoe-obyasnenie-termina-prostyimi-slovami https://Lifehacker.ru/entropy/ https://zen.yandex.ru/media/ alivespace / chto-takoe-entropiia-5d98e1ab43863f00b19f8f80 https://zen.yandex.ru/media/popsci/chto-takoe-entropiia-i-kak-ona-sviazana-s-materiei-i-energiei-5c55ad170280ed00ae : obrabezov .guru / nauka / entropiya-chto-eto-takoe-obyasnenie-termina-prostymi-slovami.html