Definição

Entropia (traduzido do grego antigo – volta, transformação) é uma medida, o grau de desordem (caos) de qualquer sistema. Usado nas seguintes ciências exatas e naturais:

- Em matemática, significa encontrar o logaritmo do número de estados do sistema disponíveis;

- Em ciência estatística, o valor probabilístico do início de qualquer estado macroscópico do sistema;

- Em termodinâmica (física), o grau de difusão irreversível de energia, ou seja, o valor padrão de suas perdas, que são inevitáveis quando um corpo mais quente interage com outro mais frio;

- Em ciência da computação, significa a capacidade de informação do sistema. Um fato interessante é o seguinte: Claude Shannon (o fundador deste termo na teoria da informação) pensava originalmente em chamar informação de entropia.

Quase complicado

Entropia é um conceito usado em mais de uma área da atividade humana, portanto, suas definições podem ser um tanto vagas. Este termo reflete um valor e sua essência pode ser desmontada com exemplos simples. Entropia é o grau de desordem, o grau de incerteza e desordem.

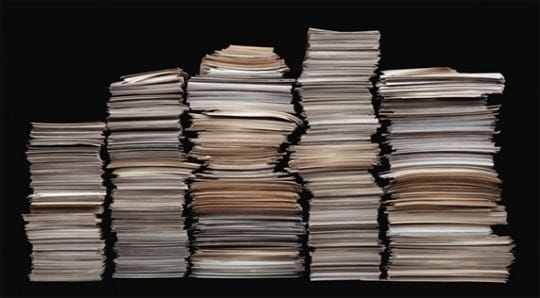

A alta entropia pode ser visualizada como uma rua com pedaços de papel espalhados. Se os papéis forem empilhados ordenadamente em uma pilha, o sistema está ordenado e a entropia é baixa. Os valores de entropia precisam ser baixados, e para isso é preciso gastar muito tempo, colar os papéis peça por peça e empilhá-los.

Se a entropia de um sistema fechado ocorre, então tudo também é simples aqui. Um sistema fechado pode ser imaginado como um armário fechado, se as coisas estão espalhadas nele, então é impossível influenciá-los de fora, e o caos no armário estará presente por muito tempo.

Com o tempo, as coisas vão se decompor, e isso vai levar à ordem, mas as coisas precisam se decompor por muito tempo, por exemplo, leva 5 anos para uma meia de lã e cerca de 40 anos para um calçado de couro. Neste exemplo, o armário atua como um sistema isolado, e a decomposição das coisas nele é colocar as coisas em ordem nas estruturas.

O mínimo é a entropia, que diz respeito a objetos macroscópicos, eles podem ser observados a olho nu. Quanto aos indicadores mais altos, eles geralmente têm um vácuo.

História de origem

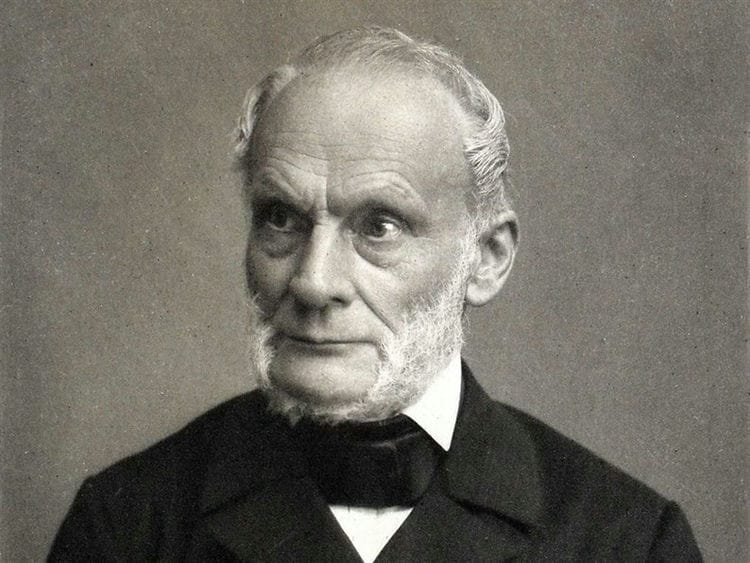

Pela primeira vez, o conceito de entropia foi introduzido na era do desenvolvimento da termodinâmica, quando surgiu a necessidade de estudar os processos que ocorrem no interior dos corpos termodinâmicos. Em 1865, um físico alemão, Rudolf Clausius, com esse termo descreveu o estado do sistema, no qual o calor tem a capacidade de se transformar em outros tipos de energia (mecânica, química, leve, etc.).

O aumento da entropia é causado pelo influxo de energia térmica no sistema e está associado à temperatura na qual esse influxo ocorre. A necessidade desse valor se deu pelo fato de toda a física se basear na idealização de objetos abstratos (pêndulo ideal, movimento uniforme, massa, etc.).

No sentido cotidiano, entropia é o grau de caos e incerteza do sistema: quanto mais ordem no sistema e quanto mais seus elementos estão subordinados a qualquer ordem, menos entropia é.

Exemplo: Um gabinete é um sistema específico. Se nele todas as coisas estão em seus lugares, a entropia é menor. Se todas as coisas estão espalhadas e não em suas prateleiras, então, conseqüentemente, ele se torna maior.

A função térmica da entalpia está intimamente relacionada a este termo – ela caracteriza o estado de um sistema termodinâmico em um estado de equilíbrio ao escolher uma série de variáveis independentes, como pressão, entropia e o número de partículas.

O oposto de entropia é chamado extropia.

Tipos de entropias

O termo é usado em termodinâmica, economia, teoria da informação e até mesmo sociologia. O que ele define nessas áreas?

Em físico-química (termodinâmica)

O principal postulado da termodinâmica sobre o equilíbrio: qualquer sistema termodinâmico isolado chega a um estado de equilíbrio com o tempo e não pode sair dele espontaneamente. Ou seja, cada sistema tende a um estado de equilíbrio para ele. E, em termos muito simples, esse estado é caracterizado por desordem.

O principal postulado da termodinâmica sobre o equilíbrio: qualquer sistema termodinâmico isolado chega a um estado de equilíbrio com o tempo e não pode sair dele espontaneamente. Ou seja, cada sistema tende a um estado de equilíbrio para ele. E, em termos muito simples, esse estado é caracterizado por desordem.

Entropia é uma medida de desordem. Como identificar uma bagunça? Uma maneira é atribuir a cada estado o número de opções com as quais esse estado pode ser realizado. E quanto mais essas formas de implementação, maior será o valor da entropia. Quanto mais organizada uma substância (sua estrutura), menor sua incerteza (aleatoriedade).

O valor absoluto da entropia (S abs.) É igual à mudança na energia disponível para uma substância ou sistema durante a transferência de calor a uma determinada temperatura. Seu valor matemático é determinado a partir do valor da transferência de calor (Q) dividido pela temperatura absoluta (T) na qual o processo ocorre: S abs. Q / T. Isso significa que ao transferir uma grande quantidade de calor, o S abs. vai aumentar. O mesmo efeito será observado para transferência de calor em baixas temperaturas.

Em economia

A economia usa esse conceito como coeficiente de entropia. Com a ajuda desse coeficiente, as mudanças na concentração do mercado e seu nível são investigadas. Quanto maior o valor do coeficiente, maior a incerteza econômica e, conseqüentemente, a probabilidade de surgimento de um monopólio diminui. O coeficiente ajuda a avaliar indiretamente os benefícios adquiridos pela empresa como resultado de possíveis atividades de monopólio ou mudanças na concentração de mercado.

Em física estatística ou teoria da informação

A entropia da informação (incerteza) é uma medida da imprevisibilidade ou incerteza de um determinado sistema. Este valor ajuda a determinar o grau de desordem no experimento ou evento que está sendo conduzido. Quanto maior o número de estados em que o sistema pode estar, maior o valor da incerteza. Todos os processos de ordenação do sistema levam ao surgimento de informações e à redução da incerteza da informação.

Com a ajuda da imprevisibilidade da informação, é possível identificar tal capacidade de canal que irá garantir a transmissão confiável da informação (em um sistema de símbolos codificados). E você também pode prever parcialmente o curso da experiência ou eventos, dividindo-os em suas partes componentes e calculando o valor da incerteza para cada um deles. Este método de física estatística ajuda a revelar a probabilidade de um evento. Com sua ajuda, você pode decifrar o texto codificado, analisando a probabilidade de aparecimento de símbolos e seu índice de entropia.

Existe uma entropia absoluta de uma linguagem. Este valor expressa a quantidade máxima de informação que pode ser veiculada em uma unidade deste idioma. Nesse caso, o símbolo do alfabeto do idioma (bit) é considerado uma unidade.

Em sociologia

Aqui a entropia (incerteza de informação) é uma característica do desvio da sociedade (sistema) ou de seus vínculos com o estado aceito (referência), e isso se manifesta em uma diminuição na eficiência de desenvolvimento e funcionamento do sistema, deterioração da personalidade -organização. Um exemplo simples: os funcionários de uma empresa estão tão sobrecarregados de trabalho (realizando um grande número de relatórios) que não têm tempo para se dedicar à sua atividade principal (realizar verificações). Neste exemplo, a medida do uso inadequado de recursos de trabalho pela gerência será a incerteza de informações.

Como a entropia se manifesta em nossas vidas

Com a ajuda da entropia, você pode explicar muitos fatos incompreensíveis e surpreendentes, por exemplo:

Por que nossa vida é tão extraordinária

Imagine o corpo humano. Os átomos que constituem o corpo poderiam ter se dobrado em um número quase infinito de variantes e não criar nenhuma forma de vida. Do ponto de vista da matemática, a probabilidade de nossa existência é muito pequena. E ainda existimos.

Em um universo onde a entropia governa tudo, a existência de vida com uma organização tão clara e estável é incrível.

Por que amamos arte e beleza

A entropia pode explicar por que a arte e a beleza nos parecem tão esteticamente agradáveis. O artista cria uma forma especial de ordem e simetria que o Universo provavelmente nunca teria gerado por conta própria. O número de belas combinações é muito menor do que o número total de todas as combinações. A beleza é uma raridade em um universo cheio de desordem. Portanto, um rosto simétrico é raro e belo, pois existem opções incomparavelmente mais assimétricas.

Por que você precisa criar as condições ideais para você?

Cada um de nós tem seus próprios talentos, habilidades e interesses. Mas a sociedade e a cultura em que vivemos não foram criadas especificamente para nós. Com a entropia em mente, considere quais são as chances de que o ambiente em que você cresceu seja ideal para liberar seus talentos?

É extremamente improvável que a vida crie para você uma situação que se adapte perfeitamente às suas habilidades. Provavelmente, você se encontrará em uma posição que não corresponde às suas habilidades e necessidades.

Geralmente descrevemos esse estado como “fora do lugar”, “fora de seu elemento”. Naturalmente, em tais condições, é muito mais difícil alcançar o sucesso, ser útil, vencer. Sabendo disso, devemos nós mesmos criar condições ideais de vida para nós.As dificuldades na vida não surgem porque os planetas estão alinhados, e não porque algumas forças superiores conspiraram contra você. É apenas a lei da entropia em ação. Existem muito mais estados de desordem do que os ordenados. Com tudo isso em mente, não é surpreendente que existam problemas na vida, mas que possamos resolvê-los.

Equação e cálculo de entropia

Existem várias maneiras de calcular a entropia. Mas as duas equações mais comuns estão relacionadas a processos termodinâmicos reversíveis e isotérmicos (com temperatura constante).

Entropia e morte por calor do Universo

Alguns cientistas prevêem que a entropia do universo aumentará a tal ponto que criará um sistema que é incapaz de um trabalho útil. E apenas a energia térmica permanecerá. O universo, dizem eles, morrerá de morte por calor.

No entanto, outros cientistas contestam a teoria da morte por calor. Eles argumentam que o universo como sistema se afasta cada vez mais da entropia. Mesmo que a entropia dentro de algumas de suas regiões internas

aumente.

Outros vêem o universo como parte de um sistema ainda maior. Outros ainda dizem que os estados possíveis não têm probabilidade igual. Portanto, as equações usuais para calcular a entropia são irrelevantes.

As formulações mais comuns de entropia na física

Muitos físicos famosos tentaram explicar o conceito de entropia de uma forma acessível para as pessoas comuns. Vamos destacar as 3 formulações mais famosas da explicação.

Declaração de Clausius

Aquecer um corpo com uma temperatura mais alta não é possível com um corpo com uma temperatura mais baixa.

Por exemplo, fica assim – você pode colocar uma chaleira com água em um pedaço de gelo (a priori, a temperatura da água é mais alta que a do gelo), mas você não pode esperar a água ferver. Embora os 2 primeiros começos da termodinâmica não neguem esta possibilidade.

Formulação de Thomson

Em um sistema fechado, um processo é impossível, cujo único resultado seria um trabalho realizado devido à energia térmica recebida de qualquer corpo.

Declaração de Boltzmann

Uma diminuição da entropia em um sistema fechado é impossível.

Esta formulação causa muita controvérsia, embora tudo seja intuitivamente claro. O caos crescerá em uma habitação abandonada – a poeira assentará, algumas coisas se desintegrarão. Você pode colocar as coisas em ordem, mas apenas aplicando energia externa, ou seja, o trabalho de um limpador.

O problema é que o Universo em conceitos modernos é um sistema fechado. Foi formado em algum lugar 14-15 bilhões de anos atrás. Durante este tempo, sua entropia levaria ao fato de que as galáxias se desintegraram, as estrelas se apagaram e nenhuma nova estrela apareceria em princípio. Mas nosso Sol não tem mais de 5 bilhões de anos, e o Universo como um todo não entrou em um estado de caos.

Entropia: teses e exemplos

Um exemplo. Programa T9. Se uma palavra contiver um pequeno número de erros de digitação, o programa reconhecerá facilmente a palavra e sugerirá sua substituição. Quanto mais erros de digitação, menos informações o programa terá sobre a palavra que está sendo inserida. Conseqüentemente, um aumento na confusão levará a um aumento na incerteza da informação, e vice-versa, quanto mais informação, menos incerteza.

Exemplo. Dados. Só existe uma maneira de descartar uma combinação de 12 ou 2: 1 mais 1 ou 6 mais 6. E o número máximo de formas é 7 (tem 6 combinações possíveis). A imprevisibilidade da implementação do número sete é maior neste caso.

- De um modo geral, a entropia (S) pode ser entendida como uma medida de distribuição de energia. Em um valor S baixo, a energia é concentrada, e em um valor alto, é distribuída caoticamente.

Exemplo. H2O (conhecido por todas as águas) em seu estado líquido de agregação terá maior entropia do que em sólido (gelo). Porque em um sólido cristalino, cada átomo ocupa uma determinada posição na rede cristalina (ordem), e no estado líquido, os átomos não têm certas posições fixas (desordem). Ou seja, um corpo com um arranjo mais rígido de átomos tem um valor de entropia mais baixo (S). O diamante branco sem impurezas tem o valor S mais baixo em comparação com outros cristais.

Exemplo. A molécula está em um vaso que tem um lado esquerdo e um lado direito. Se não for conhecido em qual parte do vaso a molécula está localizada, então a entropia (S) será determinada pela fórmula S = S max = k lgW, onde k é o número de métodos de implementação, W é o número de partes do navio. A informação neste caso será igual a zero I = I min = 0. Se for conhecido exatamente em que parte do vaso a molécula está localizada, então S = S min = k ln1 = 0, e I = I max = log 2 W. Portanto, quanto mais informação, menor o valor da incerteza de informação .

Exemplo. Quanto mais alta a ordem na área de trabalho, mais informações você pode aprender sobre o que está nela. Nesse caso, a ordenação dos objetos reduz a entropia do sistema “desktop”.

Exemplo. Há mais informações sobre a aula durante a aula do que durante o intervalo. A entropia na aula fica abaixo, pois os alunos estão sentados de forma ordenada (mais informações sobre a localização de cada aluno). E durante os intervalos, a disposição dos alunos muda caoticamente, o que aumenta sua entropia.

Exemplo. Quando um metal alcalino reage com a água, o hidrogênio é liberado. O hidrogênio é um gás. Como as moléculas de gás se movem de forma caótica e possuem alta entropia, a reação em consideração ocorre com um aumento em seu valor.

Da vida cotidiana:

- Ao escrever mensagens sms em um telefone celular, costumamos usar o programa T9. Quanto menos erros na palavra que estivermos digitando, mais fácil será o programa reconhecê-la e mais rápido nos oferecerá sua substituição. Conclusão: quanto mais confusão, maior é a incerteza da informação.

- Quando lançamos dois dados ao jogar dados, só há uma maneira de lançar uma combinação de 2 ou 12 (1 e 1, 6 e 6). O número máximo de maneiras de lançar o número 7 (6 combinações possíveis). A imprevisibilidade neste caso será máxima.

- Há mais informações sobre o número de alunos durante a aula do que durante o intervalo. Como na aula cada aluno se senta em seu lugar, a entropia é menor. Fora da sala de aula, a movimentação dos escolares é caracterizada pelo caos, o que leva a um aumento do valor da entropia.

- Se você limpar a mesa de trabalho, colocar objetos em seus lugares, poderá obter mais informações sobre este ou aquele objeto. A ordem das coisas na mesa reduz a quantidade de entropia.

Importante! Tudo o que nos rodeia tende a aumentar a entropia. Uma pessoa pretende receber o máximo de informações do mundo ao seu redor. Todas as direções teóricas no estudo da entropia (em física, química, economia, matemática, sociologia) visam estabelecer um equilíbrio (equilíbrio) entre as intenções e desejos das pessoas e os processos naturais que ocorrem na natureza.

Entropia: o que é em palavras simples

A língua russa, como qualquer outra, está em constante mudança sob a pressão de constantes empréstimos tecnológicos e da cooperação com outros estados. Graças a isso, nossa língua é rica em vários empréstimos de línguas estrangeiras.

Uma das palavras relativamente novas na língua russa foi a palavra “entropia”, que foi encontrada por muitos de nós, mas nem todos entendem o que realmente significa.

O que é entropia em palavras simples

Na maioria das vezes, a palavra “entropia” é encontrada, é claro, na física clássica. Este é um dos conceitos mais difíceis desta ciência, pois mesmo estudantes de universidades de física muitas vezes enfrentam problemas ao perceber este termo.

Esta é uma coordenada muito específica – a capital da Federação Russa – no entanto, Moscou é uma cidade bastante grande, então você ainda não sabe as informações exatas sobre minha localização. Mas quando eu digo a vocês meu, por exemplo, código postal, a entropia sobre mim, como um objeto, diminuirá.

Esta não é uma analogia totalmente precisa, portanto, daremos mais um exemplo para esclarecimento. Digamos que pegamos dez dados de seis lados. Vamos jogá-los todos um a um, e então direi o total dos indicadores eliminados – trinta.

Com base na soma de todos os resultados, você não poderá dizer com certeza qual número e qual dado caiu – você simplesmente não tem dados suficientes para isso. Em nosso caso, cada dígito descartado na linguagem dos físicos será chamado de microestado, e um valor igual a trinta, no mesmo dialeto físico, será chamado de macroestado.

Se calcularmos quantos microestados possíveis três dúzias podem nos dar no total, chegamos à conclusão de que seu número chega a quase três milhões de valores. Usando uma fórmula especial, podemos calcular o índice de entropia neste experimento probabilístico – seis e meio.

De onde veio metade, você pode perguntar? Esta parte fracionária aparece devido ao fato de que ao numerar na sétima ordem, podemos operar com apenas três números – 0, 1 e 2.

A palavra moderna “entropia” tem raízes gregas, portanto, por causa da tradução, é freqüentemente chamada de “medida do caos”. Digamos que você decida fazer um banquete em seu apartamento por ocasião do aniversário de sua filha.

Eles limparam todo o apartamento, lavaram o chão e as janelas, lavaram a louça e colocaram todos os pratos linda e elegantemente sobre a mesa. O caos doméstico inicial de seu apartamento diminuiu significativamente, portanto, sua casa se tornou um sistema com baixa entropia.

Entropia no Universo

Pelas previsões dos astrofísicos, uma das opções para o desenvolvimento do Universo é a morte por calor.

Nosso universo é (imagine como os antigos gregos eram previdentes a esse respeito) puro caos, em que algo está constantemente acontecendo: estrelas nascem e morrem, novas galáxias se formam, enfim, beleza! Em um ponto, a entropia do Universo atingirá seu máximo e simplesmente não haverá nada para acontecer nele. Tanto para a morte por ociosidade.

O caos permeia todo o cosmos, toda a nossa natureza, até os átomos e as partículas elementares. Tudo está em constante movimento e interação, como um mecanismo perfeitamente trabalhado. E todos esses processos são governados por leis que nós, miseráveis, podemos expressar em não menos bela linguagem matemática.

Mas como, com tal nível de entropia (isto é, caos) no Universo, algo poderia ter surgido? A resposta a esta pergunta é extremamente simples. Toda matéria transfere o nível de sua entropia para seu próprio ambiente, tudo que pode alcançar.

Por exemplo, para regular o nível de entropia da Terra, uma estrela chamada Sol constantemente nos fornece energia, que produz devido a uma reação termonuclear incessante em sua superfície.

Se nosso planeta fosse um sistema fechado, então, de acordo com a segunda lei da termodinâmica, a entropia dentro dele só poderia aumentar, mas, como você já entendeu, o Sol nos permite manter o nível de entropia da Terra normal.

A entropia e o caos permeiam tudo que nos cerca e até mesmo o que está dentro de nós. Em gases e líquidos, a entropia desempenha um papel fundamental, mesmo nossos desejos e impulsos momentâneos são na verdade nada mais do que um produto do caos universal universal.

Não é difícil chegar à mais bela conclusão: o Universo, por maior que seja, é uma coleção de um número infinito de partículas dos mais diversos tamanhos e não menos diversas propriedades.

Tudo nele, de um bóson elementar a Alpha Centauri e galáxias inteiras, está conectado por fios invisíveis. Essas descobertas dos físicos são impressionantes não apenas por sua complexidade, mas também por sua beleza.

Parece que as fórmulas matemáticas e físicas usuais nas tábuas de homens pensativos com barba por fazer e óculos são fatores-chave para nosso conhecimento de nós mesmos e de nosso lugar no vasto Universo.

Esperamos que este artigo tenha ajudado a esclarecer o que realmente é entropia, em quais casos essa palavra é usada e também a que a descoberta desse indicador levou cientistas e filósofos.

Quem sabe, talvez a leitura deste artigo o inspire a estudar propositalmente esta ciência maravilhosa – a física. De uma forma ou de outra, é vitalmente necessário que uma pessoa moderna se interesse pela ciência, pelo menos para o seu próprio desenvolvimento.

Finalmente

Se combinarmos todos os itens acima, descobrimos que a entropia é uma medida da desordem ou incerteza do sistema e de suas partes. Um fato interessante é que tudo na natureza tende à entropia máxima, e o homem – à máxima informação.

Fontes usadas e links úteis sobre o assunto: https://advi.club/psihologiya-i-obshhestvo/183-entropiya-prostymi-slovami.html https://obraz-ola.ru/prochee/razbiraemsya-chto-takoe- entropiya .html https://tvercult.ru/nauka/entropiya-chto-eto-takoe-obyasnenie-termina-prostyimi-slovami https://Lifehacker.ru/entropy/ https://zen.yandex.ru/media/ alivespace /-chto-takoe-entropiia 5d98e1ab43863f00b19f8f80 https://zen.yandex.ru/media/popsci/chto-takoe-entropiia-i-kak-ona-sviazana-s-materiei-i-energiei-5c55ad170280ed00aea30fbe https: // Obrazovanie .guru / nauka / entropiya-chto-eto-takoe-obyasnenie-termina-prostymi-slovami.html